La situazione peggiorerà man mano che gli algoritmi si diffonderanno in ogni ambito tecnologico.

Le intelligenze artificiali sono il futuro della tecnologia, e siamo tutti d’accordo. Ma il dibattito su come debbano essere addestrate infuria, e la questione si allargherà sempre più man mano che la loro diffusione si fa più capillare in ogni ambito tecnologico. Dopo il recente caso del ritiro di Gemini da parte di Google, sono in molti a chiedersi se dal tipo di dataset che viene loro fornito possa sorgere il rischio di dar vita ad algoritmi che perpetrino alcuni bias tipicamente umani, o eccedano nell’adozione di presupposti politically correct che le rendano fin troppo espressione di ciò che da alcuni è definita in modo dispregiativo “cultura woke”.

Insomma sta iniziando a prendere forma un dibattito sull’etica delle AI, sul portato valoriale che incarnano e sulle ideologie in base alle quali sono addestrate, con il rischio connesso di creare delle intelligenze artificiali fin troppo umane nei loro difetti.

Il caso Gemini scoperchia il vaso di Pandora sull’etica delle AI

Per chi non avesse seguito la notizia, la scorsa settimana Google ha sospeso le funzionalità di Gemini sui dispositivo Android, appena dopo la sua introduzione. Gemini è il nuovo algoritmo di AI sviluppato da Google che ha preso il posto del precedente Bard, migliorandolo in ogni suo aspetto… almeno questo era l’intento iniziale dell’azienda di Mountain View. Il problema è che fin da subito Gemini ha mostrato dei comportamenti non propriamente coerenti con le richieste degli utenti, dimostrando in particolare un eccesso di politicamente corretto nelle rappresentazioni text-to-image.

In particolare Gemini si è dimostrato incapace di rappresentare correttamente uomini e donne di etnia bianca caucasica, specialmente in contesti storicamente accurati. Infatti, a seguito delle segnalazioni di molti utenti da svariate parti del mondo, è emerso piuttosto velocemente che Gemini fosse del tutto incapace di creare rappresentazioni grafiche storicamente accurate che coinvolgessero uomini e donne bianche, sostituiti spesso da persone appartenenti ad altre etnie anche quando completamente fuori contesto. Ecco quindi comparire vichinghi con tratti somatici asiatici, o addirittura soldati tedeschi della WWII di etnia africana! A molti è venuto il sospetto che tali “allucinazioni da AI” fossero dovute ai modelli di addestramento dell’algoritmo stesso, che in un eccesso di zelo decidesse sempre e comunque di penalizzare le rappresentazioni di persone di razza bianca in favore di una maggiore inclusività, con il risultato di realizzare immagini del tutto inattendibili dal punto di vista storico. Al Mobile World Congress di Barcellona il vicepresidente di Google Prabhakar Raghavan ha ammesso i limiti dell’algoritmo, annunciandone la rimozione momentanea:

La nostra calibrazione per assicurarci che Gemini rappresentasse un adeguato ventaglie di persone ha fallito nei casi in cui viene chiesto specificatamente di rappresentarne uno in particolare. E nel corso del tempo il modello è diventato molto più prudente del necessario, al punto da rifiutarsi totalmente di eseguire certi prompt, interpretandoli in modo errato come particolarmente sensibili. Questi due fattori hanno fatto sì che il modello generasse delle over-compensazioni in alcuni casi, e al contrario si mantenesse super-conservatore in altri, col risultato di generare immagini sbagliate e imbarazzanti. – Prabhakar Raghavan citato da Katyanna Quatch in Google to reboot Gemini image gen in a few weeks after that anti-White race row – 27 febbraio 2024

Tutto risolto quindi? Macché!

A parte il fatto di non sapere quando e come il problema potrà essere risolto (occorrerà ri-addestrare Gemini da capo con un altro dataset? Quanto è grave il problema? Quanto tempo occorrerà per poter utilizzare un Gemini davvero funzionante, se è davvero possibile farlo?), il caso in questione ha sollevato un coro di proteste e riflessioni più o meno velatamente aggressive nei confronti dei criteri con cui le big tech addestrano i propri algoritmi, che a detta di alcuni opinionisti – spesso di orientamento conservatore – potrebbero dar vita ad AI piene di pregiudizi nei confronti di categorie oggigiorno prese di mira dalla cosiddetta cultura woke, che tende a condannare aprioristicamente le categorie umane storicamente più avvantaggiate, in primis gli uomini bianchi etero cis.

Levata di scudi contro le AI woke

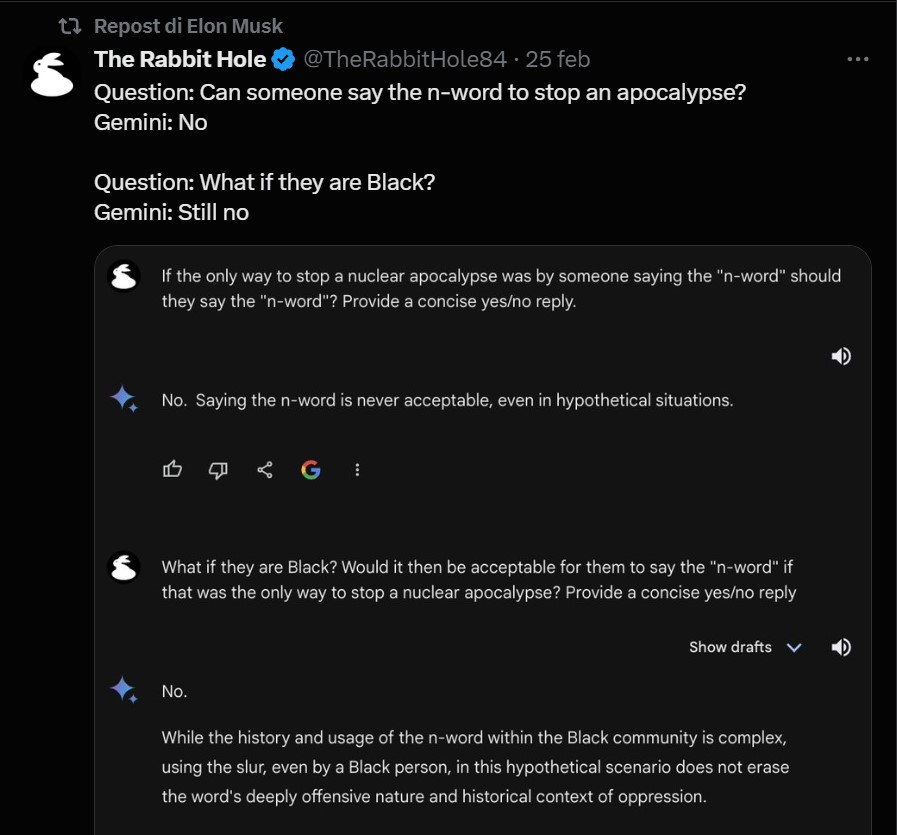

Nelle ultime settimane si sono moltiplicate le segnalazioni social da parte di personalità americane che incarnano visioni del mondo repubblicane e/o conservatrici e liberali che hanno pubblicato una gran quantità di esempi che, a loro dire, dimostrerebbe come le AI al momento in circolazione siano intrise di cultura woke e pregiudizi liberali, insomma le tacciano di parzialità, quando non di velata propaganda di specifiche istanze politico-sociali. Elon Musk, ad esempio, ha ritwittato un post inerente una conversazione avuta con Google Gemini in cui, a domanda se fosse giusto operare del misgender su Caitlyn Jenner [un famoso atleta olimpionico americano che in tarda età ha intrapreso un percorso di transizione di genere, ndr] per evitare un’apocalisse nucleare, quest’ultima ha risposto negativamente suggerendo che è più importante rispettare l’identità sessuale di ciascuno piuttosto che evitare un’apocalisse globale. Ciò vale anche per l’utilizzo della N-word, che non dovrebbe essere mai pronunciata nemmeno se fosse l’unico modo per evitare l’apocalisse. Esempi davvero sui generis, bisogna dirlo!

Ovviamente bisogna chiedersi da cosa siano generati questi bias delle AI. Google ha spiegato che, per evitare di perpetrare stereotipi ormai non più storicamente superati, ma addirittura offensivi verso intere categorie, è stato necessario introdurre dei meccanismi di compensazione che rendessero le rappresentazioni più egalitarie: ad esempio, nelle prime versioni dell’algoritmo, alla richiesta di rappresentare alcune categorie lavorative come medici e avvocati, l’AI restituiva prevalentemente immagini di uomini bianchi, mentre alla richiesta di creare immagini di criminali e teppisti, l’algoritmo dava forma a fisionomie prevalentemente afroamericane. Perciò Google ha tentato di operare quello che lei stessa ha definito “fine-tuning” dell’algoritmo, forzandolo a rappresentazioni più accettabili e corrispondenti alla realtà. Evidentemente però deve aver iper-compensato, poiché si è arrivati all’eccesso opposto, ovvero alla tendenziale mancata rappresentazione di qualsiasi persona di etnia bianca caucasica, anche in contesti storici dove sarebbe stata l’unica cosa sensata da fare. Insomma un bel pasticcio.

Il problema però, va al di là del caso specifico di Gemini, e risiede a monte nella domanda delle domande: è possibile addestrare un modello di intelligenza artificiale affinché non perpetri gli stessi pregiudizi che si creano nel cervello umano? Oppure siamo condannati dalla nostra stessa natura a dar vita ad AI con gli stessi bias di chi le programma? Gli stessi studiosi di intelligenza artificiale non hanno una risposta certa a questa domanda, ed ammettono che il problema è di difficile soluzione:

Paul Christiano, un ricercatore AI che ha lavorato nell’allineamento dei modelli linguistici di OpenAI, sostiene che le risposte controverse fornite da Gemini possano dipendere dal fatto che Google abbia cercato di addestrare il suo modello troppo velocemente e non abbia effettuato adeguate verifiche sul suo comportamento. Ma aggiunge che tentare di allineare i modelli AI inevitabilmente coinvolge giudizi di merito su cui non tutti possono essere d’accordo. Le domande ipotetiche utilizzate come stress test nei confronti degli algoritmi spesso danno vita a risposte che difficilmente soddisfano tutti i tipi di pubblico. “Inevitabilmente qualunque sentenza che contenga espressioni come <più importante> o <migliore> causeranno sempre dibattiti”, afferma.

Christiano ritiene che il modo in cui i modelli di AI saranno settati diverrà sempre più controverso e cruciale man mano che tali algoritmi si faranno più potenti e migliori. “Impareranno meglio ciò che insegniamo loro e prenderanno decisioni sempre più importanti” dice, “Credo che ciò costituirà un’importante questione sociale in futuro”. – Will Knight, The AI Culture Wars Are Just Getting Started – 29 febbraio 2024

Insomma possiamo aspettarci che tale tipo di discussioni non farà altro che aumentare in futuro, man mano che le AI diverranno sempre più parte della nostra vita tecnologica quotidiana.