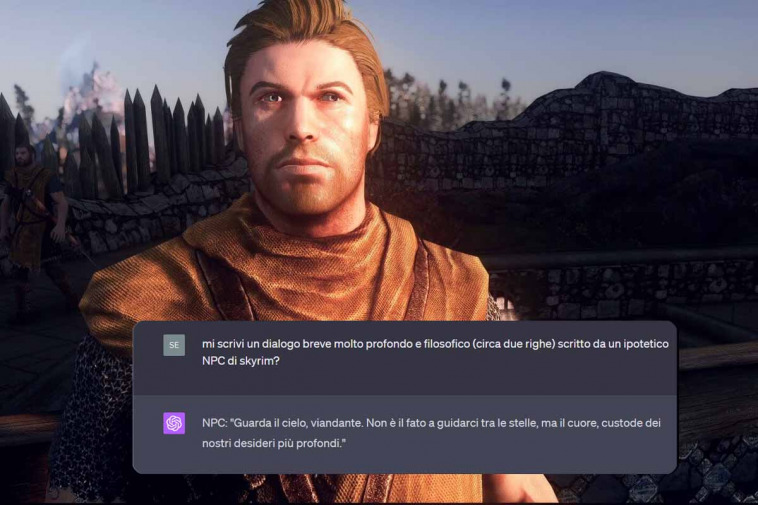

L’IA generativa può diventare il futuro dei dialoghi nei videogiochi. Dotare gli NPC di un’IA in grado di comunicare in modo umano e di adeguarsi a ciò che ha appreso del mondo di gioco può portare i giochi a un livello di realismo e di immersione senza precedenti, soprattutto per quanto riguarda gli RPG. Nvidia ha gettato le basi proprio su tale argomento, presentando un progetto molto interessante.

l’IA generativa può svolgere un ruolo significativo nel futuro dei dialoghi nei videogiochi. L’idea di dotare gli NPC di un’IA avanzata in grado di comunicare in modo più umano e di adattarsi al mondo di gioco offre molte opportunità per aumentare il realismo nei giochi di ruolo e in tutti quei titoli in cui i dialoghi e la narrativa sono di fondamentale importanza per offrire al giocatore un’esperienza immersiva.

Con l’IA generativa, gli NPC possono essere programmati per generare risposte e dialoghi in modo più dinamico e naturale. Questo significa che possono reagire in modo più realistico alle azioni del giocatore e offrire una varietà di risposte in base al contesto e alle informazioni che hanno appreso nel mondo di gioco. Inoltre, l’IA può adattarsi alle scelte del giocatore, memorizzarle e rispondere in modo coerente nel corso del gioco.

Ciò permette di creare esperienze di gioco più coinvolgenti e personalizzate. Immaginate di avere una conversazione con un personaggio non giocante che si ricorda delle vostre scelte passate e vi offre dialoghi e missioni in base a esse. Questo tipo di interazione più profonda può contribuire a creare un mondo di gioco più realistico e soddisfacente da vivere ed esplorare.

Nvidia getta le basi: NPC che parlano con noi come fossero umani

Al Computex 2023 tenutosi a Taipei, capitale di Taiwan, il CEO di Nvidia Jensen Huang ha dato al mondo un assaggio di come potrebbe essere l’incontro tra videogiochi e intelligenza artificiale, con un rendering graficamente mozzafiato di un negozio di ramen cyberpunk in cui è possibile parlare con il proprietario.

Nella demo mostrata, l’NPC non risponde a una domanda con frasi precalcolate, ma fornendo informazioni che in quel momento risultano coerenti con il contesto. Ma cosa più interessante, non ci sono opzioni di dialogo, ma un singolo input a seguito del quale il giocatore interagisce con la propria voce.

Non possiamo essere sicuri di quanto ci sia di dinamico e quanto di calcolato aprioristicamente, ma è senza dubbio intrigante pensare che gli NPC possano rispondere in modo naturale e in modo sempre diverso da giocatore a giocatore, da partita a partita. Nvidia la definisce una “sbirciatina al futuro dei giochi“.

Sfortunatamente, il dialogo effettivo non è così incredibile, anche perché si tratta di un singolo momento, pertanto non è possibile farsi un’idea sul lungo periodo.

Ecco l’intera conversazione tradotta:

Giocatore: Ehi Jin, come stai?

Jin: Purtroppo non bene.

Giocatore: Come mai?

Jin: Sono preoccupato per la criminalità qui intorno. Ultimamente la situazione è peggiorata. Il mio negozio di ramen è stato coinvolto in scontri a fuoco.

Giocatore: Posso aiutarti?

Jin: Se vuoi fare qualcosa, ho sentito dire che il potente signore del crimine Kumon Aoki sta causando ogni tipo di caos in città. Potrebbe essere lui la causa di questa violenza.

Giocatore: Gli parlerò, dove posso trovarlo?

Jin: Ho sentito dire che frequenta i club di lotta clandestini nella zona est della città. Prova lì.

Giocatore: Ok, ci vado.

Jin: Stai attento, Kai.

Guardando un singolo video di una singola conversazione, è difficile capire come questo possa avere effetto sull’esperienza di un RPG da 80 ore, ma la cosa impressionante è che l’intelligenza artificiale generativa reagisce al parlato naturale. Speriamo che Nvidia rilasci la demo in modo da poterla provare personalmente e ottenere risultati radicalmente diversi.

La demo è stata realizzata da Nvidia e dal partner Convai per promuovere gli strumenti utilizzati per crearla, in particolare una suite chiamata Nvidia ACE (Avatar Cloud Engine) for Games che può essere eseguita sia localmente che nel cloud. L’intera suite ACE include gli strumenti dell’azienda per l’implementazione di modelli linguistici di grandi dimensioni (LLM), speech-to-text e text-to-speech, tra le altre cose.

Nel corso di un incontro preliminare al Computex, il vicepresidente di Nvidia per la piattaforma GeForce Jason Paul ha detto la tecnologia è in grado di gestire più di un personaggio alla volta e che in teoria potrebbe anche permettere agli NPC di parlare tra loro, ma ha ammesso di non averla mai provata.