Se conoscete qualche vero appassionato del mondo Android e di Google, allora saprete che alle 18:15 di ieri (8 Maggio) è letteralmente sparito per starsene incollato allo schermo e seguire la diretta del Google I/O. Perché, sotto il sole battente di quelle che, in California, erano appena le 9:15 di mattina, si è tenuto l’appuntamento annuo degli sviluppatori Google. Appuntamento in cui hanno informato il Mondo su cos’è che dovrà aspettarsi per il futuro dall’azienda di Mountain View. Non tutti hanno avuto occasione di starsene inchiodati al pc, ma questi ultimi sono comunque in buone mani. A cosa servirebbe altrimenti avere una redazione di nerd di fiducia?

Delle tre giornate che si sono susseguite, solo la prima è stata realmente rivolta al grande pubblico. Durante il 9 ed il 10 Maggio, infatti, le conferenze, i seminari ed i workshop svolti dall’azienda di Mountain-View hanno trattato argomenti estremamente tecnici, orientandosi verso gli esperti dello sviluppo di software e del machine learning. Tra tali argomenti va menzionata l’applicazione del machine learning al campo della ricerca medica e dello sviluppo di tecnologie sanitarie.

Cosa ci riserva Google

L’azienda di Mountain-View ha da subito messo in chiaro la direzione che vorrà prendere nel prossimo anno. Anzi, più opportunamente: da questo momento fino ad un indefinito futuro. Si tratta in un certo senso di continuare su di un percorso che aveva già iniziato a tracciare negli ultimi anni. Quello che ci viene detto, in apertura di questo evento, non ci suona nuovo. Eppure, nonostante la prevedibilità della strada scelta, le tappe che conta di raggiungere e i traguardi che taglierà nei prossimi mesi sono tutto meno che scontati. In due parole (che nel corso di questa giornata ricorreranno parecchio) la strada scelta è il Machine Learning. O, più nello specifico, il Deep Learning.

“We want to make the smartphone smarter” diranno, senza girarci troppo attorno. IA, dunque: algoritmi che evolvono e imparano le abitudini dei loro utilizzatori, ma anche un Google Assistant sempre più umano, un’inedita interconnessione tra i servizi, le app ed i dispositivi che Google può oggi offrire. Il tutto unito da una lucida comprensione delle responsabilità che un colosso come Google ha nel modo in cui il mondo usa e vive le tecnologie che gli vengono proposte.

È difficile, con tutte le novità che l’azienda di Mountain View ha spiattellato sotto il sole, disporle in un’ordine di succosità. Noi ci abbiamo provato, però. Tenetevi forte e, se non aveste un quarto d’ora per aggiornarvi in tranquillità sul futuro di Google, sentitevi liberi di utilizzare l’indice qui sotto per navigare agilmente tra le informazioni che più vi fanno gola.

Android P: il nuovo Android pensato per il Machine Learning e la sua nuova interfaccia

- Adaptive Battery & Adaptive Brightness: per gestire al meglio i consumi.

- App Action & Slice: novità per le app suggerite e l’interfaccia.

- Shush, Wind Down e Digital Wellbeing: queste funzioni consentiranno, se lo si desidera, di rendersi meno reperibili e non permettere allo schermo del cellulare di tenerci svegli.

- Android P, quando e su quali dispositivi: tutti i dettagli per partecipare alla beta.

Google Assistant: sempre più umano.

- Google Duplex, Wavenet, Continued Conversation, Multiple Action: conversazioni fluide, comprensione dinamica ed un assistente che telefona per noi e prende appuntamento.

- Un assistente più visuale: una migliore gestione su schermo delle risposte interattive che ci fornirà l’assistente.

- Insegnare la buone maniere: tramite la funzione Pretty Please, l’assistente Google fornirà rinforzi positivi ai bambini che gli chiederanno le cose “per favore”.

Google News: in guerra contro le fake news.

- Full Coverage & Newscast: due nuove funzioni per gestire al meglio il vortice di informazioni digitali.

Schermi e lenti intelligenti: nuove tecnologie, per un nuovo sistema operativo ed un nuovo assistente.

- Smart Display: Avete presente Google Home? Ci hanno messo uno schermo.

- Google Lens: Tradurre scritte fisiche presenti nel mondo reale e copia-incollarle trasferendole sul digitale non è mai stato così facile.

- Walking Navigation & VPS: Google Maps si integra con la Realtà Aumentata. Non catturerete Pokèmon per le strade di una città, ma se seguirete una volpe virtuale non potrete perdervi.

Altre Novità, relative a Gmail, Google Maps, Google Photo e Waymo: le macchine che si guidano da sole.

_______________________________

Android P

Il nuovo sistema operativo è pensato per apprendere, rendere il vostro telefono più intelligente, ottimizzare il vostro tempo, semplificarvi la vita, integrarsi in profondità con l’universo Google e migliorare l’interazione con l’Assistente. Solo in parte è stato possibile ottenere ciò grazie agli inevitabili cambiamenti nell’interfaccia. Quando si presentano cambiamenti del genere non sempre i fan sono entusiasti, ma sono, in questo caso, solo la punta dell’iceberg. L’interfaccia si presenta svuotata e semplificata, vi è una sola area touch nella parte centrale e in fondo allo schermo grazie alla quale si riuscirà a fare praticamente tutto.

Il nostro telefono ci si presenterà con l’area di ricerca Google spostata dall’alto verso il basso, le nostre cinque app elette come app di punta subito sopra, un calendario molto basic con eventuali impegni imminenti ed il meteo in cima ed il fatidico pulsante in fondo a tutto. Si potrà far scivolare tale pulsante verso l’alto per avere accesso alle ultime app utilizzate di recente e a quelle ancora aperte in background, ci verranno inoltre mostrate cinque app consigliate dall’IA del nostro telefono che imparerà a conoscerci sempre di più. Nel remoto caso in cui l’algoritmo si sbagliasse e le app che ci servissero non fossero ancora a portata di mano si potrà far scivolare nuovamente il dito verso l’alto per scoprire tutte le app che abbiamo scaricato e selezionare “manualmente” quella che ci interessa. Ovviamente facendo scivolare il dito verso il basso si tornerà alla schermata precedente. Degno di nota è il fatto che tale tocco, a prescindere se sia rivolto verso l’alto o verso il basso, può essere effettuato in qualsiasi momento e non solamente dalla schermata Home, permetto di passare agevolmente da un’app all’altra. Sarà anche possibile far scorrere il pulsante centrale in fondo allo schermo verso sinistra o verso destra per slittare tra le app aperte in background. Oltre a tutto questo, Android P ha fatto anche alcuni piccoli e validi accorgimenti. Tramite i bottoni laterali l’audio che si va ad abbassare ed alzare adesso è sempre prioritariamente l’audio dei media e non della suoneria del telefono in sé (che potrà comunque essere messa in silenzioso tramite il normale procedimento). Inoltre il riorientamento dello schermo è stato vincolato ad una veloce pressione in un punto dello stesso, così da evitare che, quando si tenta di cambiare posizione al telefono, lo schermo ruoti più volte caoticamente prima di “capire” qual’è la nuova posizione che deve assumere.

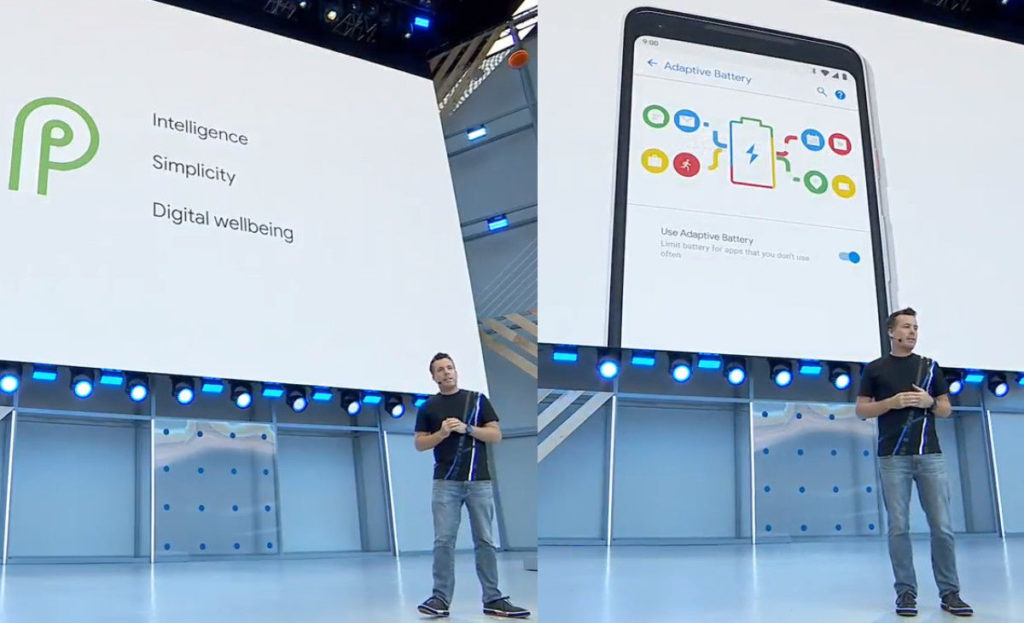

Adaptive Battery & Adaptive Brightness

Deep Learning significa anche e soprattutto “adattamento”. Adattamento all’utente, alle sue abitudini e alle sue necessità. Queste due nuove features di Android P promettono proprio questo: un sistema intelligente di gestione della batteria e della luminosità dello schermo.

Una volta comprese quale app apriamo realmente più spesso e quali sia meglio tenere “pronte per l’uso” e quali, invece, possano essere messe a dormire fin quando non decideremo effettivamente di riaprirle quell’una tantum, il nostro telefono riuscirà a risparmiare circa il 30% della sua batteria totale. Inoltre la vita della stessa batteria risulterà prolungata. Per quanto concerne la retroilluminazione dello schermo, Android P sembra essere in grado di conciliare il grado di luminosità che dimostriamo di apprezzare maggiormente con l’effettiva luminosità ambientale, così da aggiustarsi non solo in base a quanta luce ci sia attorno a noi, ma anche in base alle nostre preferenze che abbiamo dimostrato durante l’utilizzo. Anche questa feature, in ogni caso, promette di allungare ulteriormente la durata della nostra batteria.

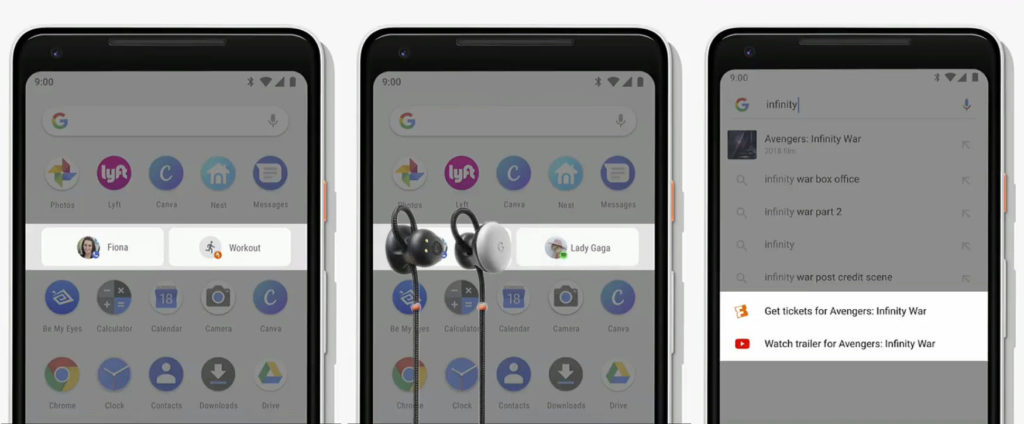

App Action & Slices

Queste due features sono parte integrante della nuova interfaccia di Android P e dell’idea dietro la sua progettazione. Svuotare così tanto l’interfaccia, infatti, ci semplificherà realmente la vita solo se tutto restasse davvero a portata di mano: se liberarci di una foresta di app in prima linea sia una buona idea o no dipenderà solo dal fatto che, quando ci serviranno, le app rimosse si dimostreranno in grado di apparire prontamente sotto il nostro dito.

App Action altro non è che l’evoluzione delle vecchie “applicazioni consigliate“, già introdotte in Android l’anno scorso. Se, prima, il dispositivo era in grado di consigliarci le applicazioni utilizzate di più, adesso egli incrocia le informazioni sulle nostre abitudini settimanali con l’orario di quel particolare momento del giorno e con i dati relativi agli utilizzi specifici di questa o quell’altra app. Non ci consiglierà più solamente l’app “Contatti”, ma ci consiglierà di chiamare nostra sorella nel momento della giornata in cui siamo soliti farlo. Se poi fosse quel giorno della settimana in cui lei lavora fino a tardi e noi non la chiamiamo mai non disperate: Android P lo saprà. Similmente Slice ci permetterà di utilizzare applicazioni dentro altre applicazioni. Il nostro smartphone adattivo, infatti, utilizzerà i suoi nuovi algoritmi d’apprendimento per capire quando è il caso di aprire una finestrella di just-eat dentro la pagina Google su cui abbiamo cercato: ristoranti vicini, e così via.

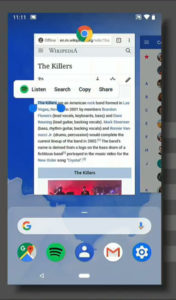

Altri interessanti utilizzi dell’App Action riguardano la “Smart Text Selection“. Android P può fare di più che suggerirvi quale applicazione utilizzare quando siete voi a scrivere qualcosa nella barra di ricerca di Google.

È in grado, infatti, di offrivi suggerimenti anche se poggiate il dito su qualcosa scritto da altri, è il caso di quest’ultimo esempio, in cui semplicemente cliccare sul nome di una band permette eventualmente di aprire Spotify per ascoltarne qualche brano.

Shush, Wind Down e Digital Wellbeing

Nell’introduzione si è detto come Google si stia facendo carico delle proprie responsabilità. Con questo non si intende dire che chi produce tecnologia ha una responsabilità diretta sul modo in cui questa viene utilizzata, ma, piuttosto, che l’accelerazione nello sviluppo elettronico ed informatico e l’interconnessione a cui le nostre vite sono attualmente sottoposte ha prodotto una serie di effetti indesiderati che Google sembra decisa quantomeno ad attenuare. Tutte queste contromisure per permettere alle persone di essere più “scollegate”, vivere di più la vita in prima persona e non sprofondare per intere giornate nel mondo virtuale, rientrano nella sfera di quello che durante il Google I/O è stato definito “Digital Wellbeing“. Tenete questo concetto bene a mente: sono molte, infatti, le novità che Google ha da offrire in tal senso e molto probabilmente se ne parlerà anche nelle giornate successive di questo evento.

In questa sede parleremo, anzitutto, della nuova gesture. Code Name: Shush.

Gli sviluppatori di Google hanno recepito molti feedback relativi al fatto che, anche tenendo il telefono in silenzioso, il continuo arrivo di notifiche che fa illuminare lo schermo e vibrare il dispositivo è una potenziale fonte di distrazione. La tentazione di controllare cosa sia successo o chi ti abbia scritto è spesso troppo forte e si finisce per riprendere il telefono tra le mani. Con la conseguenza che, una volta riafferrato, una cosa tira l’altra e ci si ritrova di nuovo inchiodati allo schermo per almeno una decina di minuti buoni.

La soluzione? Prendere il cellulare ed appoggiarlo su di una superficie piatta con lo schermo rivolto verso il basso. Così facendo il telefono entra in modalità “Do Not Disturb” (attivabile, in ogni caso, anche senza eseguire necessariamente questa nuova gesture detta, appunto, “Shush“) e smetterà di illuminarsi, vibrare o squillare. Si potranno ovviamente selezionare alcune specifiche persone esonerate da questo filtro totale, così che nello sfortunato caso in cui si stesse vivendo un’emergenza di qualche tipo, i diretti interessati potranno raggiungerci anche all’interno della nostra bolla di realtà, ricavata con tanta fatica dal continuo pulsare della reperibilità virtuale.

In aggiunta alla modalità Do Not Disturb e allo Shush, inoltre, una feature definita Wind Down è stata aggiunta per permettere alle persone di sbarazzarsi più facilmente del cellulare una volta che si sono infilate sotto le coperte. È stato dimostrato infatti come la continua osservazione di schermi luminosi di notte possa ridurre la produzione di melatonina e facilitare l’insorgere dell’insonnia (sono le 03:13 e sto scrivendo un’articolo al pc: fidatevi di me). Grazie a Wind Down, una feature a detta degli stessi sviluppatori “estremamente semplice, ma efficace”, sarà possibile impostare un determinato orario dopo il quale lo schermo diventerà in bianco e nero. Questo dovrebbe essere più che sufficiente a consentire all’utente di piazzare lo smartphone sul comodino più in fretta e mettersi a dormire.

Si è lavorato, inoltre, su un sistema per “addensare” le notifiche provenienti da una stessa applicazione, così da farle arrivare assieme anziché sparse e ad intermittenza nell’arco della giornata e, infine, si è migliorata la Dashboard.

La Dashboard è quell’area di Android dove normalmente viene registrato quanto tempo della propria giornata si dedica su questa o quell’app. Con Android P si avrà la possibilità aggiuntiva di inserire un timer e decidere preventivamente quanto tempo dedicare ad ogni applicazione. Quando il tempo sta per scadere, il timer ci avvisa con una notifica. Quando scade l’icona dell’applicazione diviene grigia, per avvisarci del fatto che abbiamo esaurito il tempo che avevamo deciso di riservare a quella specifica applicazione. Possiamo comunque, ovviamente, continuare ad utilizzare il nostro dispositivo quanto desideriamo, ma questo accorgimento punta a renderci più padroni delle nostre attività e più consapevoli dello scorrere del tempo.

Android P, quando e su quali dispositivi

Android P sarà disponibile per più dispositivi, non solo sui dispositivi Pixel di Google.

L’elenco attuale, comunque in espansione, è il seguente:

Google Pixel, Pixel 2, Pixel XL e Pixel 2XL.

Nokia 7 Plus.

Vivo X21 ed X21UD.

OnePlus 6.

Xiaomi Mi MIX 2S.

Sony Xperia XZ2.

Essential Phone.

Oppo R15 Pro.

Le richieste di partecipazione alla beta sono già aperte, noi ancora non l’abbiamo avuto occasione di provarlo, ma rimedieremo presto. Nel frattempo, questo è il link per partecipare.

Google Assistant

Anche l’Assistente Google cambierà nel prossimo futuro. La parola chiave, in questo caso, è “umanità”. L’obiettivo dell’azienda di Mountain View è quello di dare l’impressione di interloquire con una persona in carne ed ossa e, se fino ad oggi non si può dire siano riusciti nell’impresa, le cose stanno per cambiare radicalmente. Nonostante il Deep Learning possa essere applicato con successo ad ogni branca dell’informatica, è quando va ad arricchire una vera e propria IA che mostra il suo massimo potenziale.

Google Duplex, Wavenet, Continued Conversation, Multiple Action

Se, di recente, Google Assistant ha fatto parlare di sé in relazione a Google Home ed è stato al centro di diversi confronti con altri prodotti, difficilmente questi potranno anche solo sperare di avvicinarsi alla direzione che il Google Assistant sembra aver ormai imboccato. Anzitutto: la voce. Se, prima, la voce dell’assistente era costruita accostando sillabe, suoni, parole tutt’al più, grazie al Machine Learning si sono date in pasto all’IA centinaia di frasi lette da diversi attori. L’IA ha così iniziato a prestare attenzione all’onda sonora in sé, all’emissione continua del suono lungo la durata dell’intera frase. Questa tecnica, detta “Wavenet“, è alla base dell’eccezionale fluidità e naturalezza che le nuove voci disponibili (ben 6) hanno dimostrato di possedere durante il Google I/O.

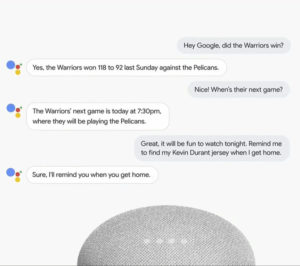

Al Wavenet si aggiunge la Continued Conversation, che permetterà all’assistente di proseguire una conversazione iniziata senza aver bisogno di ricevere continuamente l’ “Ehy Google” come input. Inoltre egli sarà in grado di fare facilmente riferimento a quanto detto in precedenza all’interno della stessa conversazione, contestualizzando il discorso e comprendendo con più naturalezza l’area semantica di riferimento delle varie domande che gli verranno poste.

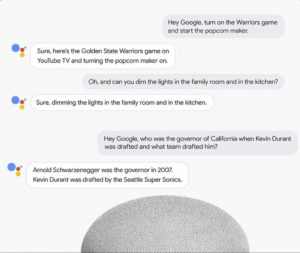

In ultimo, tramite la feature chiamata Multiple Action, il Google Assistant sarà ora in grado di svolgere due o più richieste contemporaneamente. Potrà eseguire più compiti domotici all’interno dello stesso ordine, o comprendere le correlazioni tra diversi aspetti di una domanda. I risultati sono a dir poco impressionanti.

E non è finita qui. Poiché ci rendiamo conto che “leggere” tali risposte non sia sorprendente quanto il sentirle, l’azienda di Mountain View ha un’altro importante ruolo da assegnare al Google Assistant.

Non danno garanzie di riuscirci entro l’anno, ma i test sono già iniziati. Il vostro segretario personale diverrà in grado di telefonare ad un’attività che non consente prenotazioni on-line e prenotare per voi. Avete capito bene. Non vi metterà in contatto con tale attività, no. Telefonerà e parlerà al vostro posto, come un segretario o una segretaria in carne ed ossa. Tale è la fluidità nell’espressione, la rapidità di comprensione del linguaggio e la capacità di apprendimento ed improvvisazione che la telefonata appare in tutto e per tutto svolta da un essere umano. Non ci credete?

Avete appena assistito a due reali telefonate effettuate da Google Duplex.

Potremmo passare ore a parlare delle profonde conseguenze e le innumerevoli applicazioni di questa tecnologia.

È ovvio, tuttavia, che dovremo attendere qualche anno extra per sperare in un dialogo uomo-macchina così fluido in lingua italiana.

Un assistente più visuale

Google Assistant non si limiterà a parlare meglio, ma anche a sfruttare in maniera più intelligente lo schermo del vostro smartphone per mostrarvi prontamente le risposte che gli chiedete, o gli esiti delle operazioni cui lo farete dedicare. Inoltre la sua compatibilità verrà estesa ulteriormente: sarà possibile ordinare del cibo limitandosi a chiederlo con un “Ehy Google”, si potrà controllare Google Maps tramite l’Assistente facendo ogni sorta di richiesta, come far partire un brano mentre si guida senza che Google Maps venga chiuso e molto altro. L’Assistente verrà reso “immersivo, interattivo e proattivo“.

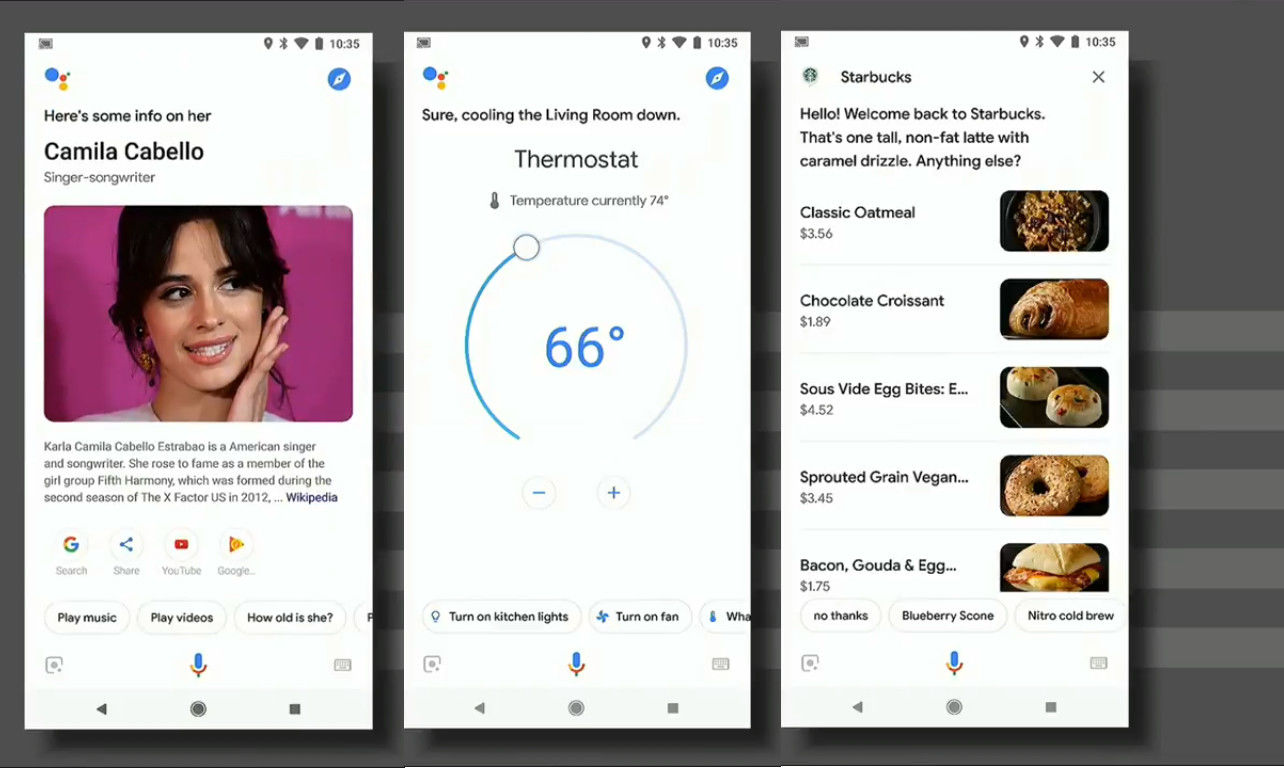

Ecco alcuni esempi di come si comporterà con lo schermo del vostro Smartphone:

Chiunque abbia un po’ di dimestichezza con il vecchio Google Assistant noterà la differenza. Da notare le opzioni consigliate sotto l’esito della ricerca, che consentono di ascoltare la musica della cantante in questione, la possibilità di gestire il termostato direttamente dallo schermo del cellulare ed il fatto, nell’ultimo dei tre esempi, che l’Assistente Google sappia qual’è “il solito” (“the usual”, ha chiesto effettivamente l’utilizzatrice) che normalmente viene ordinato dal suo utente a Starbucks.

Abbiamo anche parlato di proattività. Nell’ottica del Digital Wellbeing, l’azienda di Mountain View intende con questo termine quelle funzioni che propongono all’utente attività di vario genere, stimolandolo come possono a dedicarsi ad una vita sociale non esclusivamente virtuale. Google Assistant non mancherà di consigliare attività, basandosi sulle condizioni meteorologiche, su cosa c’è o non c’è vicino a dove ci troviamo, sulle attività che abbiamo già inserito nella nostra agenda e, ovviamente, sui nostri gusti e preferenze.

Insegnare le buone maniere

Parte del Digital Wellbeing è anche il rapporto che i più piccoli iniziano ad avere con le nuove tecnologie. Lo sviluppo rapidissimo del settore informatico ha prodotto una nuova generazione di nativi digitali di cui sappiamo ancora poco. Il 10 Novembre dello scorso anno Sean Parker ha dichiarato: “Solo Dio sa cosa Facebook sta facendo al cervello dei bambini”. Premesso che l’Assistente Google è stato riempito di storie della buona notte da raccontare ai nostri pargoli quando si mettono a letto (un po’ inquietante, in effetti), qualche genitore aveva segnalato che i propri figli iniziavano a diventare particolarmente arroganti e “trattavano con prepotenza” il povero assistente virtuale, dandogli ordini a destra e a manca. Google ha dunque inserito la feature “Pretty Please”, che fa sì che l’Assistente ringrazi e si mostri compiaciuto ogni volta che un bambino gli chiede qualcosa e poi aggiunge un “per favore”, utilizzando un sistema di rinforzi positivi per aiutare i genitori in quello che è senza dubbio il mestiere più difficile di tutti. Specie di questi tempi.

Google News

Grandi cambiamenti coinvolgono anche l’aspetto più strettamente correlato all’informazione di quello che, almeno in origine, era un semplice motore di ricerca. Anche in questo caso i portavoce dell’azienda di Mountain View affermano di sentire una grande responsabilità addosso: sempre più persone si rivolgono a Google per ottenere delle reali informazioni in base alle quali formare le proprie idee e decidere della propria vita. L’aggiornamento di Google News, dunque, non è solamente estetico (per quanto l’interfaccia sia stata completamente modernizzata, resa più dinamica e personale), ma mira anche a combattere apertamente le fake news tramite la funzione “Full Coverage”.

Full Coverage & Newscast

Una home page con le cinque notizie che “stanno avvenendo adesso” e che “non puoi non sapere”, una selezione di altre notizie in base ai tuoi interessi, una seconda selezione in base alla loro rilevanza e alla loro popolarità ed un’ultima selezione di notizie locali, dipendente dalla tua posizione. A questo si aggiunge la possibilità di scegliere quale testata seguire ed, eventualmente, se sostenere o meno i nostri giornalisti preferiti.

Full Coverage sfrutta il Deep Learning per distinguere il vero giornalismo dalle bufale, ma fa di più. Permette di confrontare i diversi punti di vista su ogni questione, mettendo nella stessa pagina articoli con tesi contrastanti e contornandoli di analisi di esperti opinionisti.

Newscast, d’altro canto, procede per aree tematiche. Individua un tuo interesse e costruisce un collage di causa-effetto che, nello spazio di meno di metà dello schermo del tuo telefono, ti informerà sugli sviluppi più recenti di quelle tematiche e, al tempo stesso, ti fornirà molte curiosità ed informazioni a cui normalmente avresti avuto difficilmente accesso. “Cose che non avresti potuto scoprire altrimenti”.

Schermi e lenti intelligenti

Google non si è limitata a far interagire meglio Google Assistant con lo schermo degli smartphone. Dal punto di vista dell’immersione visuale il futuro ci aspetta molte piacevoli sorprese.

Smart Display

Ci siamo tutti chiesti, all’uscita di Google Home, se, chiedendo a Google di effettuare una ricerca, lo speaker si sarebbe limitato a leggere ad alta voce tutta la pagina di wikipedia o avrebbe fatto apparire il tutto sul nostro telefono. Gli Smart Display sono esattamente quello che dovrebbero essere: un Google Home con uno schermo.

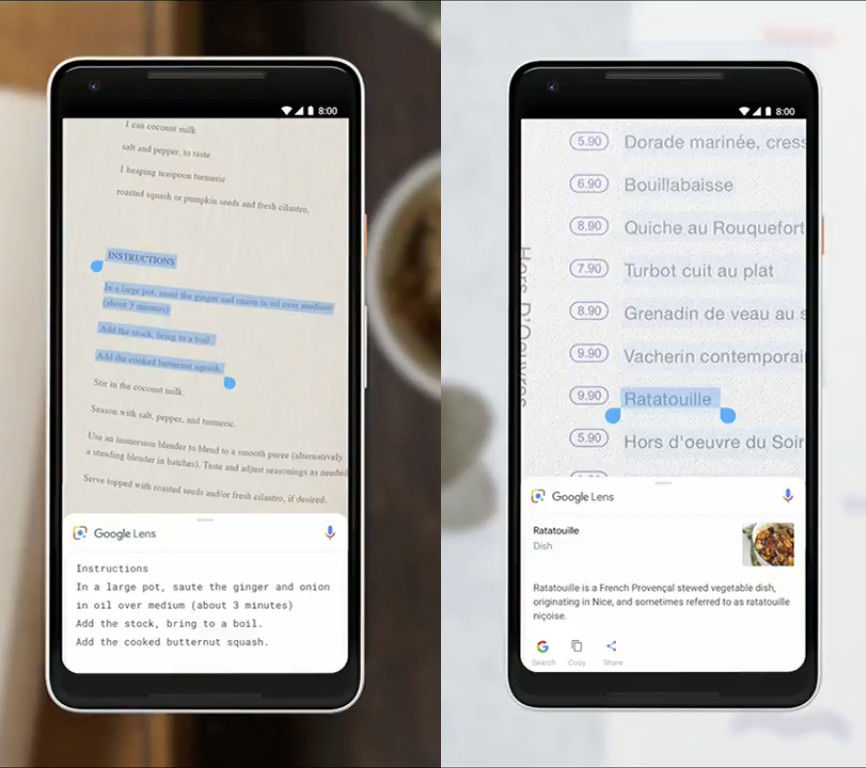

Google Lens

Le Google Lens diventeranno il metodo definitivo di incorporare la realtà aumentata nella nostra vita. Almeno nel breve periodo. Se fino ad ora servivano principalmente ad usare la fotocamera per ottenere informazioni sui vari monumenti sparsi per il mondo, ora le cose cambieranno drasticamente. Anzitutto le informazioni che appariranno sul nostro schermo quando inquadreremo qualcosa con la nostra fotocamera lo faranno in tempo reale, secondariamente le lenti cesseranno di riconoscere solo luoghi iconici ed impareranno a riconoscere praticamente qualsiasi cosa. Parole comprese. Questo, combinato con l’App Action di Android P (di cui si è già parlato) infliggerà un durissimo colpo alla barriera che separa il mondo delle cose concrete dall’universo digitale. Potrete inquadrare un cane per far partire in automatico una ricerca e far apparire in tempo reale la razza di appartenenza e le relative informazioni sul vostro schermo, potrete inquadrare un prodotto in una vetrina di un negozio per far materializzare quello stesso prodotto su Amazon e farvi un’idea del suo prezzo on-line e potrete addirittura cercare prodotti simili. Attraverso la feature dello Style Match e, ovviamente, un’enorme quantità di dati processati tramite il Deep Learning, sarà ora possibile individuare oggetti presenti in rete che starebbero bene con quel cappotto o quella borsa che è là davanti a voi, o lampade e tavolini che avrebbero senso nel salotto dell’amico da cui state prendendo un caffè. Vi basterà solo inquadrare il tutto. Per quanto riguarda la comprensione delle parole, inoltre, non serve che vi spieghi quante possibilità apra assieme alla già citata “Smart Text Selection“.

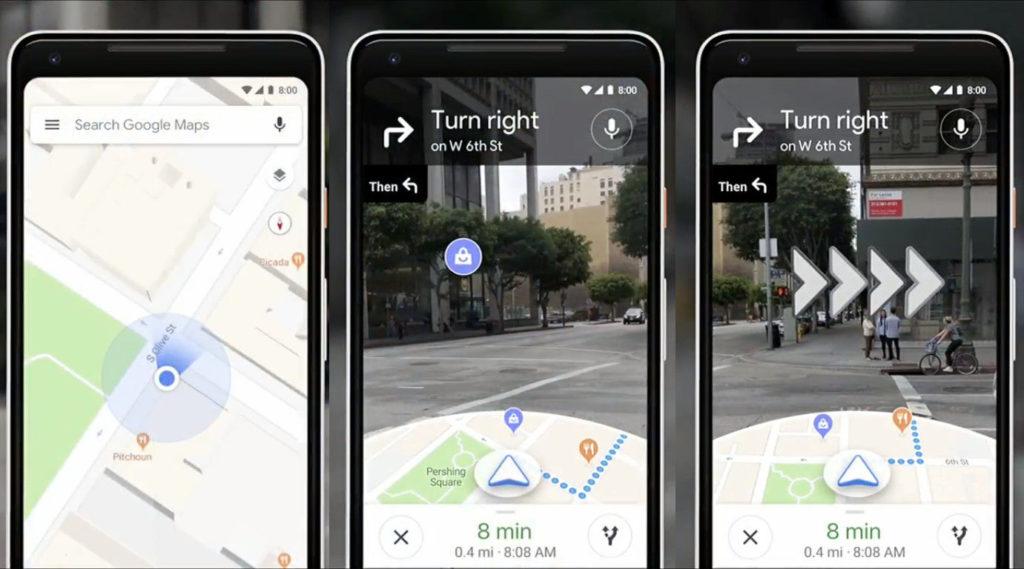

Walking Navigation & VPS

Google ha davvero superato sé stessa, tuttavia, unendo quanto ottenuto da Google Lens, con Google Map e con il nuovo sistema di localizzazione. Avete presente quando avete la pessima idea di utilizzare Google Maps per andare da qualche parte con i mezzi pubblici e magari, sbucati fuori dalla metropolitana, non sapete esattamente cosa avete attorno ed iniziate a camminare avanti e indietro nella speranza di capirci qualcosa in base al modo in cui si muove quel maledetto pallino azzurro? Ecco. Mai più.

La Walking Navigation permetterà di visualizzare sullo schermo della fotocamera l’avvicinarsi di attività segnalate in Google Maps, il nome delle strade che si affacciano sulla via che state percorrendo e vi permetterà di spostarvi “mappa in mano” senza rischiare di farvi investire da una macchina di passaggio. C’è anche l’opzione (per davvero) di inseguire una simpatica volpe che vi condurrà direttamente dove volete andare.

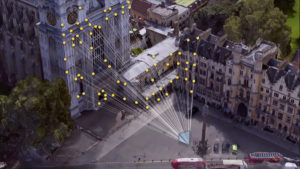

Un sistema così preciso è stato reso possibile solo con il passaggio dalla tradizionale localizzazione GPS al VPS: Visual Position Service, che sfrutta l’angolazione con cui Google Lens percepisce, tramite la fotocamera, ciò che ci circonda.

Le altre novità

Molte altre cose sono state aggiornate e rivedute. E alcune interessanti porte su di un possibile futuro sono state aperte. In breve, riassumiamo anche questi ultimi punti per i più curiosi.

Gmail

Non poteva certo mancare tra gli aggiornamenti. Il Deep Learning può ben applicarsi anche alla stesura delle e-mail, infatti. In questo caso, la vostra fidata applicazione dovrebbe riuscire letteralmente a concludere le frasi che state scrivendo prima che riusciate a mettere il punto fermo. Vi basterà premere TAB per accettare la proposta che apparirà, cambierà ed evolverà man mano che aggiungete lettere. L’applicazione riuscirà a desumere il contesto dell’e-mail dall’Oggetto che avete inserito, offrendo indicazioni sempre più precise man mano che verrà utilizzata.

Google Maps

Anche senza Walking Navigation Google Maps ha subito un notevole miglioramento. Diverrà in grado di calcolare il traffico con molta più precisione e aiuterà gli autisti a trovare più comodamente parcheggio. Inoltre, grazie alla politica proattiva rivolta al Digital Wellbeing, ti consiglierà nuovi posti appena aperti nella tua zona o locali nei dintorni particolarmente popolari in quel momento. Ti permetterà anche di raggruppare varie attività in una shortlist e condividerla con i tuoi amici, per votare con un tocco del dito cosa fare questa sera, scegliendo il locale o il luogo in cui vedersi.

Google Photo

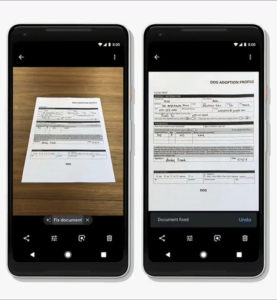

Google Photo vi renderà molto più semplice modificare le vostre foto, applicare filtri, rendere lo sfondo di un ritratto in bianco e nero e condirà il tutto con altre simpatiche features. Degno di nota è il fatto che riesce a colorare foto originariamente fatte in bianco e nero con estrema precisione e che, effettuando una foto ad un foglio buttato su di un tavolo, questo può essere tramutato in pdf in un istante. A prescindere dall’angolazione e dalla prospettiva della foto il risultato sarà quello di una scansione.

Waymo

In conclusione all’evento, Google ha annunciato la trasformazione di Waymo in un’azienda a sé, comunque parte del macrosistema Alphabet: la holding di Google. Waymo è l’azienda leader mondiale nella ricerca e sviluppo di auto in grado di guidarsi da sole. Tramite il Deep Learning, mettendo in condivisione tutte le esperienze affrontate, le miglia e le miglia percorse e le cose “apprese” dalle singole vetture, Waymo punta alla creazione di un guidatore perfetto, più che di una macchina del futuro, con il fine ultimo di rendere le nostre strade più sicure e di garantire uno spostamento tranquillo a tutti. Anche a chi non può o non ha mai potuto guidare.