Durante il primo OpenAI DevDay la compagnia ha presentato diverse novità; tra le più interessanti possiamo senza dubbio inquadrare il nuovo GPT-4 Turbo e, sopratutto, gli agenti GPT, questi ultimi capaci di lavorare anche con informazioni caricate dall’utenza finale.

Quale tecnologia è più sulla cresta dell’onda di tutto quel pastrocchio che risponde al nome di intelligenze artificiali generative? Plausibilmente niente al momento ha più trazione di ciò per il grande pubblico, che passa sicuramente un po’ di tempo ogni giorno a cercare di capire come queste grandi aziende si muoveranno durante il corso dei prossimi anni.

Gli addetti ai lavori, invece, sono già qualche passo avanti, a vedere gli ultimi ritrovati in termini di codice e di strumentazioni. Durante il corso del primo OpenAI DevDay, il primo evento ufficiale patrocinato da Open AI (con alle spalle la ancora più imponente Microsoft), l’azienda americana ha presentato diverse novità legate al mondo dell’intelligenza artificiale generativa.

Tra queste le più interessanti per il pubblico tutto sono certamente due: da una parte il modello GPT-4 Turbo, destinato a offrire ancora più possibilità operative a che pensa che il normale GPT-4 (quello con l’abbonamento per intenderci) gli vada stretto, dall’altra la possibilità molto interessante di creare dei cosiddetti agenti GPT.

Analizziamo un po’ più nel dettaglio cosa vogliono dire queste due novità per chi utilizza il prodotto di Sam Altman e soci.

GPT-4 Turbo: cos’è e come funziona?

GPT-4 Turbo è il nome della versione rinnovata nel noto modello linguistico utilizzato dalla versione a pagamento di ChatGPT. Se la versione base di ChatGPT è stata addestrata su informazioni rimaste ferme fino a Gennaio del 2022 (questo aggiornamento è stato piuttosto recente, appena uscito al pubblico il sistema era a conoscenza soltanto delle informazioni presenti in rete fino a Settembre 2021), GPT-4 Turbo è addestrato con dati che risalgono ad Aprile 2023: molto meglio per chi vuole elaborare informazioni recenti.

Tra le altre cose Altman, durante l’evento, ha promesso che OpenAI cercherà di rendere più frequenti i processi di aggiornamenti dei modelli, così da venire maggiormente incontro alle esigenze dei suoi clienti.

Sebbene avere informazioni più aggiornate sia di per sé utile, probabilmente lo è meno rispetto l’ingrandimento della context window di Chat GPT, che arriva finalmente a 128.000 token.

Cos’è la context windows?

Con questo termine nell’ambito degli LLM ci si riferisce al quantitativo di testo o informazioni che il modello riesce a tenere in considerazione quando elabora informazioni alla ricerca di una risposta. Questo significa che più è grande la context Window, più informazioni possono essere date in pasto a ChatGPT per ottenere la risposta in questione.

Con il termine token, invece, si definisce l’elemento minimo in cui i modelli linguistici leggono testi e ne generano altrettanti; di norma questo può essere o un carattere o una parola intera, a secondo del tipo di lavoro che il sistema deve fare.

Cosa si può fare con 128.000 token? Secondo OpenAI ora il suo modello di linguaggio è in grado di creare risposte che analizzano fino a 300 pagine di testi per interagire a un singolo prompt; un risultato davvero di prim’ordine se consideriamo che il prodotto commerciale con le prestazioni più simili si fermava ai centomila token.

Un’altra caratteristica molto apprezzata di questa nuova iterazione di GPT-4 Turbo sarà senza dubbio la possibilità di gestire più azioni per prompt; sebbene a una prima occhiata questo possa non sembrare interessante, in realtà per strumenti complessi che utilizzano GPT come interfaccia collegata ad apparati in grado di agire significa poter risparmiare cifre anche importanti sui costi di utilizzo.

I programmatori saranno felici di sapere che con la versione Turbo il sistema è in grado di esportare risposte in formato JSON, con la capacità di realizzare algoritmi deterministici migliori grazie all’introduzione di un nuovo parametro chiamato seed. Tornando invece agli utilizzi più comuni non possiamo far altro che citare la possibilità, finalmente, di poter utilizzare in input anche immagini; esempi dei possibili utilizzi riguardano la generazione di didascalie, l’analisi visiva, la lettura di documenti; finché l’analisi del contesto non è indispensabile GPT-4 turbo può fare un buon lavoro.

GPT-4 Turbo sarà disponibile per gli utenti di GPT-Plus durante il corso delle prossime settimane; GPT-3.5 sarà invece aggiornato durante lo stesso periodo di tempo a una versione con context windows pari a 16.000 token e supporto all’esportazione di file in JSON.

Il mio nome è GPT, agente GPT

Ancora più interessanti, ma anche più difficili da definire se non si è dei totali addetti ai lavori sono gli agenti GPT, da qui in poi definiti semplicemente come GPT.

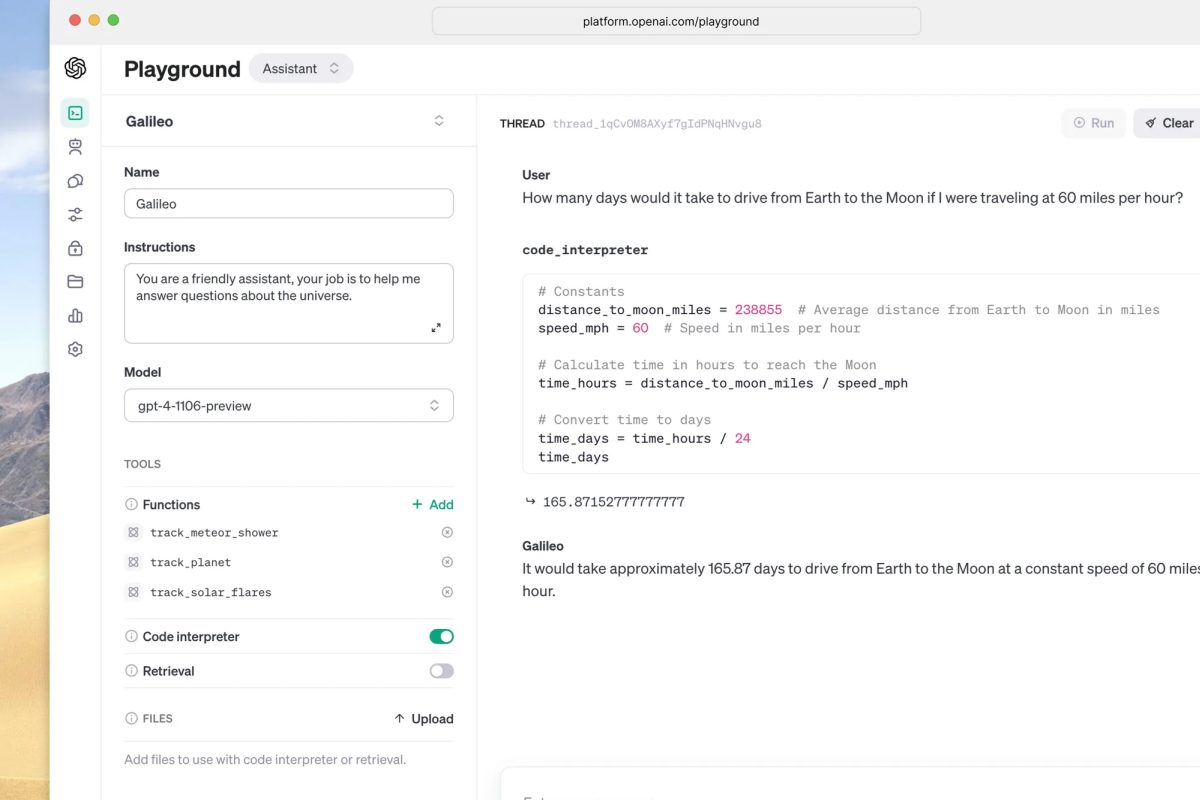

Gli utenti plus, sostanzialmente, avranno la possibilità di creare delle versioni personalizzate di ChatGPT che è possibile addestrare in maniera specifica sulla base di materiali che si mettono a disposizione del sistema. L’utente in sostanza può crearsi il suo chatbot, specializzato nell’argomento che preferisce e dotato di un determinato stile di risposta.

L’addestramento che viene fatto dall’utente, in questo caso, non va a toccare l’intero modello linguistico bensì serve al bot per poter integrare nelle risposte informazioni di cui non sarebbe normalmente a disposizione, senza contare la possibilità di generare risposte ancor più personalizzate rispetto al normale. In ambito business parliamo, ad esempio, di schede tecniche, di manuali d’istruzione di prodotti specifici o di procedura non presenti su internet.

Per creare un agente GPT non è necessario sapere nulla di codice: l’interfaccia messa a disposizione dalla piattaforma è abbastanza semplice da essere alla portata di tutti; interessante anche la possibilità, per l’utente, di rendere disponibile l’agente GPT anche ad altri o di renderlo privato soltanto per l’utilizzo aziendale.

Particolare attenzione è stata riposta dall’azienda nella gestione dei documenti dati in pasto all’agente GPT personalizzato di qualcuno; se l’agente GPT è privato i documenti in questione non saranno in alcuna maniera utilizzati per il training del GPT generico, rispettando così le leggi sulla privacy che faticosamente il sistema sta provando a integrare all’interno del suo sistema.

Le possibilità, in sostanza, sembrano essere illimitate e durante il corso dei prossimi mesi sarà davvero interessante cercare di capire cosa si potranno inventare gli utenti più smanettoni con tutta questa potenza di fuoco per le mani.

Resta da capire se veramente è stata posta tanta attenzione nella gestione delle informazioni con o se, fra qualche mese, vedremo dei titoli con su scritto “OpenAI denunciata da 9999 aziende diverse per insider trading e altre malvagità”: voi su che scommettete tra queste due opzioni?