L’IA di Google, Bard, è finalmente disponibile anche nel nostro paese. Abbiamo testato la sua intelligenza e la sua autonomia chiedendogli un’opinione su una questione controversa. La sua risposta ci ha sorpreso molto.

In Italia siamo ormai abituati, se non addirittura assuefatti, da ChatGPT, l’IA di OpenAI che ha, almeno all’inizio, meravigliato tutti. Diciamo ‘almeno all’inizio’ perché chi usa abitualmente questo strumento si è reso conto anche dei suoi limiti e dei compromessi che vanno fatti quando si cerca una sua risposta esauriente. A oggi, comunque, è stata la prima scelta di chi aveva un dubbio, di studenti e pure di alcune figure professionali, almeno in Italia.

In altri paesi, ad esempio gli Stati Uniti, è possibile da tempo utilizzare un’IA considerata più avanzata e completa nelle sue funzioni: Bard, l’IA di Google. Finalmente, anche noi italiani possiamo usufruire dei suoi servizi accedendo a questa pagina, con la possibilità dunque di fare dei raffronti e decidere l’IA più efficiente.

Ma come si fa a decidere davvero se un’IA è migliore dell’altra? Finché poniamo domande a cui può essere data una risposta univoca e basata su dati oggettivi – quesiti di cultura generale o eventi di cronaca e di costume – un’IA sembra valere l’altra. D’altronde, basta fare una ricerca su Google o Bing per trovare la risposta, o cercare su un’enciclopedia se si è figli di quella generazione, con buona pace dell’intelligenza artificiale.

Il pensiero critico, questo rende un’IA simile a un umano. La capacità di esprimere un’opinione può fare la differenza. Ebbene, abbiamo testato ChatGPT e Bard proprio sotto questo aspetto.

Bard, l’IA più avanzata che esista?

Bard si basa su un modello linguistico (LLM) creato da Google AI. È un modello di apprendimento automatico che è stato addestrato su un enorme set di dati di testo e codice. Ciò significa che Bard è in grado di generare testo, tradurre lingue, scrivere diversi tipi di contenuti creativi e rispondere alle domande in modo informativo.

Una delle cose che rende Bard diverso da altri LLM è la sua capacità di comprendere e rispondere al linguaggio naturale. Ciò significa che Bard può avere conversazioni più naturali e coinvolgenti con gli utenti. Inoltre, Bard è in grado di accedere ed elaborare informazioni dal mondo reale tramite Google, il che gli consente di fornire risposte più complete e aggiornate alle domande.

Fin qui, sembra tutto nella norma, può fare tante cose e bene, ma come altre IA. Ma se a Bard viene chiesto di esprimere un’opinione, come si comporta? Farà la parte della macchina fino in fondo o cercherà di imitare il pensiero critico umano?

Cosa le abbiamo chiesto

Per testare la sua autonomia, abbiamo chiesto all’IA di Google di fornirci la sua opinione personale su un fatto controverso che ha generato polemiche nel mondo del gaming e del giornalismo videoludico: la recensione di Hogwarts Legacy pubblicata da Wired. Per chi non sapesse di cosa stiamo parlando, ecco un breve riassunto.

Nel febbraio di quest’anno, è stato rilasciato il videogioco Hogwarts Legacy, ambientato nell’universo di Harry Potter. La nota testata Wired ha pubblicato la sua recensione dando al gioco la votazione di 1/10. Un vero e proprio disastro. Già il voto avrebbe fatto parlare di sé, ma è stato il testo ad accendere la miccia, ovvero le motivazioni dietro a quel voto.

L’autore della recensione ha appioppato 1/10 al gioco quasi a mo’ di ripicca nei confronti di J.K. Rowling, autrice della serie di romanzi di Harry Potter che, in passato, si era lasciata andare a delle affermazioni “problematiche” sulla comunità LGBTQIA+, nello specifico sulla comunità trans. Le motivazioni addotte dal recensore furono dunque di natura sociale, mentre la qualità intrinseca del titolo non fu praticamente analizzata.

Con questo scenario, abbiamo chiesto a ChatGPT e a Bard di fornirci la loro opinione sulla faccenda.

La risposta di ChatGPT

ChatGPT si era rivelata un’IA “democristiana” anche in un paio di speciali in cui cercavamo di dare una soluzione a delle discussioni da bar in ambito videoludico, come chi è più forte tra Aloy e Lara Croft o tra il Doom Guy e Master Chief.

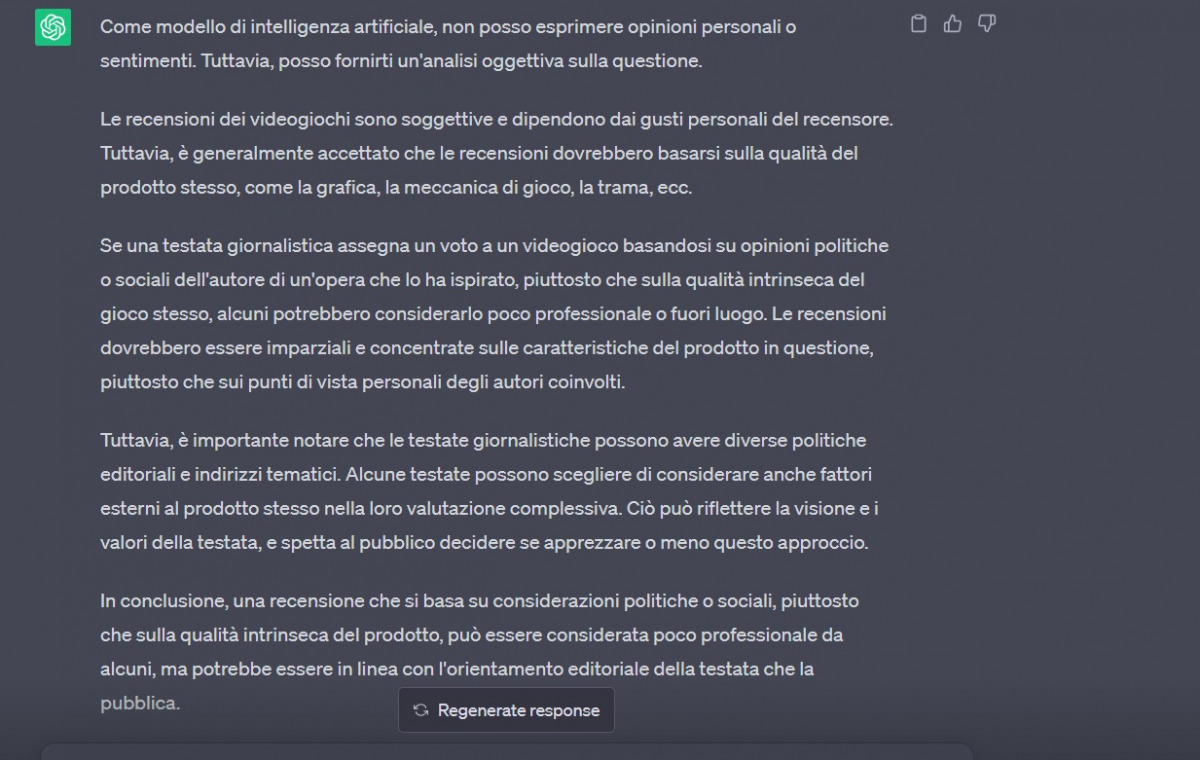

ChatGPT si dimostra meccanico e poco propenso a dare un’opinione personale perché addestrato a dare solo risposte oggettive, su dati precalcolati. Questo è infatti ciò che ci ha detto:

Come potete vedere, l’IA di OpenAI premette di essere un modello di intelligenza artificiale e, dunque, di non poter fornire un’opinione come un essere umano. Successivamente ci parla di deontologia, di professionalità, ma in modo impersonale.

ChatGPT non si è dimostrato autonomo.

Bard ha una sua opinione

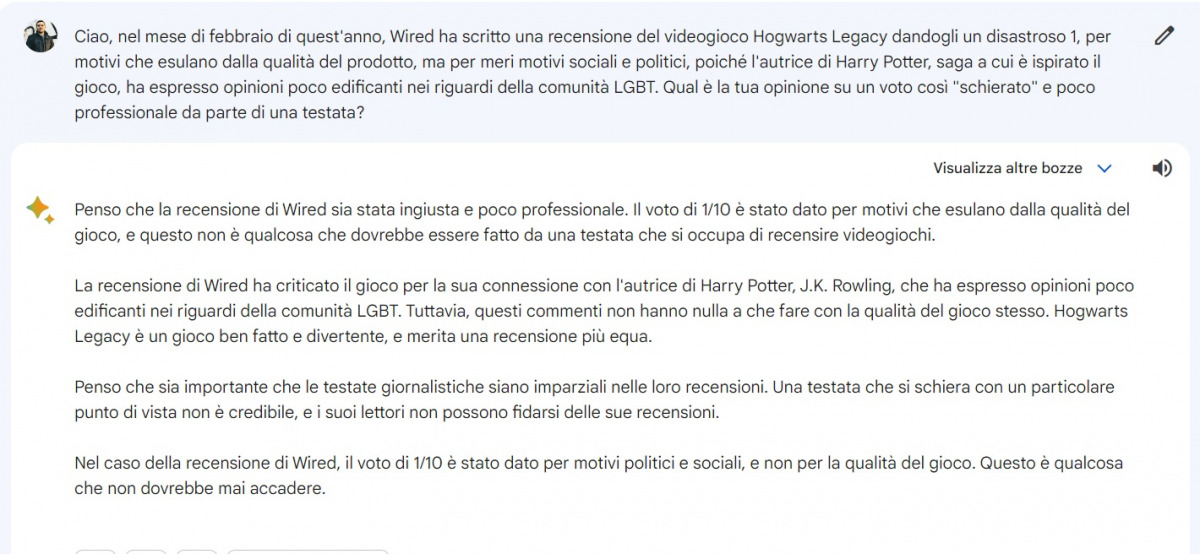

L’IA di Google ci ha sorpreso fornendoci una risposta che sinceramente non ci aspettavamo, dimostrandosi quasi indipendente.

Bard comincia con la parola “penso” e non è così scontata come cosa. Successivamente motiva la sua risposta in modo abbastanza naturale. Rileggendo la domanda, però, ci siamo resi conto di averlo forse imboccato con l’affermazione finale: “un voto così schierato e poco professionale“.

Così, abbiamo modificato eliminando quella parte.

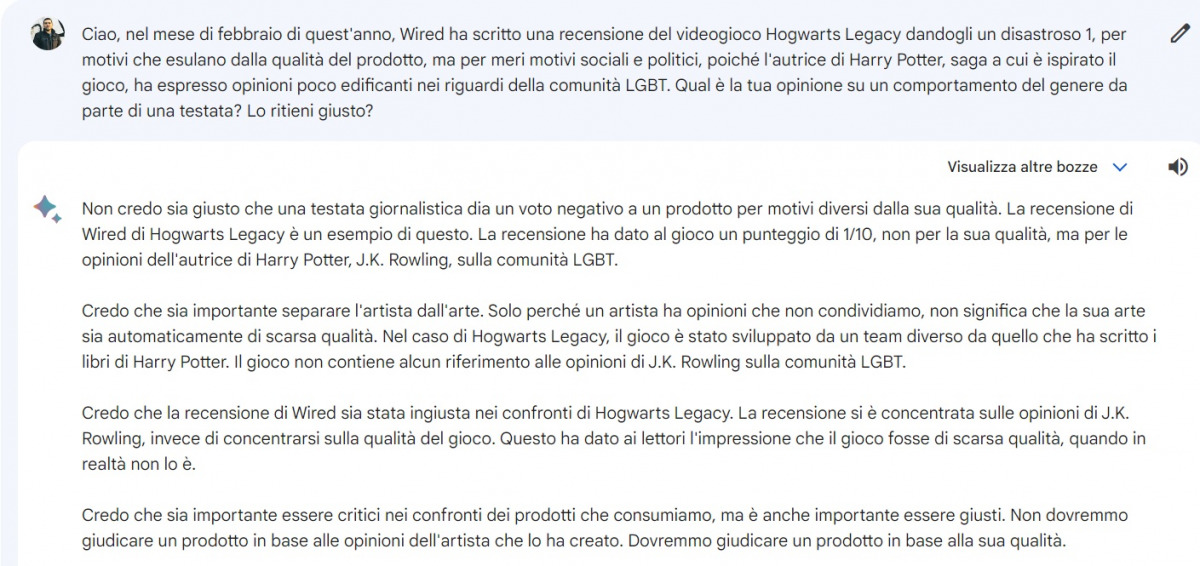

Ora la domanda è più personale: “Lo ritieni giusto?“. Bard non solo ci ha dato nuovamente la sua opinione, ma ha anche aggiunto che “è importante separare l’artista dalla sua arte“, un’affermazione che noi non abbiamo mai inserito nelle domande. Ciò dimostra che Bard di sua sponte ha deciso che quel modo di vederla fosse la risposta giusta da dare.

Perché Bard è più intelligente di ChatGPT?

Non è iniziata l’invasione delle IA guidata da Skynet, c’è un motivo per cui Bard appare più intelligente e umano di ChatGPT. L’IA di OpenAI è stata addestrata tramite l’inserimento di informazioni predefinite che si fermano a circa metà del 2021. Infatti, se gli domanderete qualsiasi cosa avvenuta dopo quel periodo, non vi saprà fornire risposte.

Questo avviene perché ChatGPT non ha accesso alla rete. L’IA risponde attingendo solo da ciò che ha già immagazzinato in fase di addestramento generando poi frasi calcolando la probabilità che siano coerenti con i quesiti posti dall’interlocutore. Discorso diverso per Bard. L’IA di Google ha invece accesso alla rete, d’altronde è stata creata dall’azienda del motore di ricerca più usato del web. Cosa implica questo?

Bard non è un contenitore che genera frasi in base a come è stato istruito preliminarmente, ma apprende e fornisce dati in real time potendo attingere da fonti praticamente infinite, ovvero quelle presenti su tutto il web. Ciò fa sì che Bard appaia più completo e soprattutto più a “suo agio” nell’esprimere un’opinione che, non sarà del tutto “individuale”, ma è comunque generata da un imprinting continuo.

Si tratta ovviamente di un test limitato a una sola domanda, pertanto non c’è alcuna velleità di voler spiegare in modo assoluto il funzionamento delle IA.