ChatGPT l’ha combinata grossa. Le sue affermazioni riguardo a un giornalista americano non sono piaciute al diretto interessato che ha denunciato OpenAI per diffamazione. Non è la prima volta che l’IA inventa di sana pianta le informazioni che fornisce nelle sue risposte.

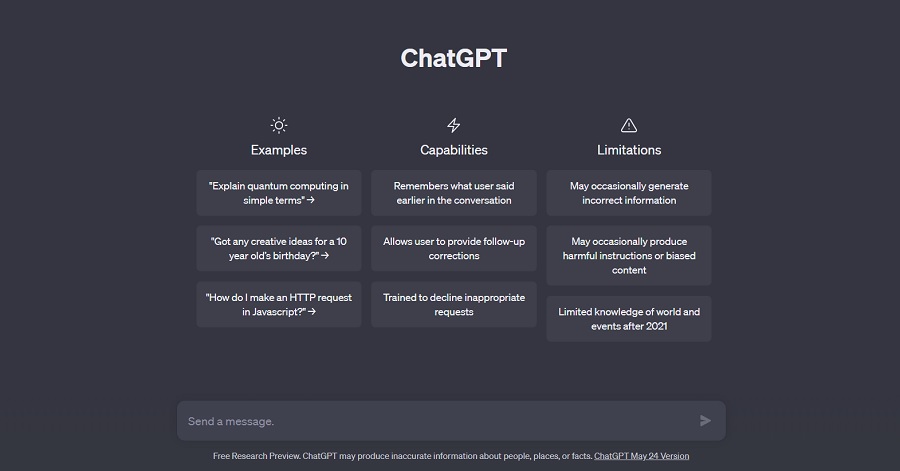

Anche le IA possono avere le allucinazioni. In gergo, queste si chiamano hallucinations e, sebbene a volte possano far sorridere, possono avere anche ripercussioni gravi. Le “hallucinations” di cui può cadere vittima ChatGPT si riferiscono a situazioni in cui il modello genera risposte che possono sembrare realistiche, ma che non si basano su fatti verificabili o informazioni corrette.

Questo può accadere a causa della natura generativa del modello e della sua capacità di combinare e riproporre informazioni apprese durante l’addestramento. Tuttavia, poiché ChatGPT non ha una comprensione profonda del mondo reale o la capacità di verificare la veridicità delle informazioni, potrebbe occasionalmente fornire risposte che non sono accurate o che sembrano convincenti ma non sono supportate da dati reali.

Su Player, vi abbiamo già parlato di questo fenomeno quando vi abbiamo raccontato del caso dell’avvocato Steven Schwartz. L’uomo di legge, preso forse anche un po’ dalla pigrizia, ha chiesto all’IA di elencargli tutti i casi simili a quello che stava seguendo lui in quel momento, ovvero quello di Roberto Mata, un signore che ha fatto causa alla compagnia area Avianca Airlines dopo essere stato colpito da un carrello di servizio.

Purtroppo, i casi citati dall’IA si sono rivelati tutti falsi, cosa che ha fatto fare all’avvocato una figuraccia in tribunale. Ebbene, un altro caso di hallucinations è avvenuto e questa volta a essere denunciata è proprio l’azienda che ha sviluppato l’IA.

ChatGPT ha diffamato un giornalista

OpenAI è stata colpita da quella che sembra essere la prima causa per diffamazione nei confronti di un’IA in seguito alle false informazioni generate da ChatGPT.

Un conduttore radiofonico della Georgia, Stati Uniti, Mark Walters, ha citato in giudizio l’azienda dopo che ChatGPT ha dichiarato che Walters era stato accusato di frode e appropriazione indebita di fondi da un’organizzazione no-profit. Il sistema ha generato le informazioni in risposta a una richiesta eseguita da un altro giornalista di nome Fred Riehl. Il caso di Walters è stato depositato il 5 giugno presso la Corte Superiore della Georgia, nella Contea di Gwinnett, e chiede a OpenAI un risarcimento monetario non specificato.

Il caso è degno di nota, viste le diffuse lamentele sulle false informazioni generate da ChatGPT e da altri chatbot. Questi sistemi non hanno un modo affidabile per distinguere i fatti dalla finzione e, quando viene chiesto loro di fornire informazioni – in particolare se si tratta di confermare qualcosa che l’interlocutore umano suggerisce essere vero – spesso inventano date, fatti e cifre solo per “accontentare” la richiesta.

La causa per diffamazione intentata da Walters in Georgia potrebbe essere un precedente molto impattante sullo sviluppo futuro delle IA. Il caso afferma che un giornalista, Fred Riehl, ha chiesto a ChatGPT di riassumere un caso reale di una corte federale collegandosi a un PDF online. ChatGPT ha risposto creando un falso riassunto del caso, dettagliato e convincente, ma sbagliato sotto diversi aspetti. Il riassunto di ChatGPT conteneva alcune informazioni di fatto corrette, ma anche false accuse contro Walters. Si affermava che Walters avrebbe sottratto fondi a un’organizzazione no-profit per i diritti delle armi chiamata Second Amendment Foundation “per oltre 5.000.000 di dollari“. Walters non è mai stato accusato di questo.

Riehl non ha mai pubblicato le false informazioni generate da ChatGPT, ma ha verificato i dettagli con un altro soggetto. Non è chiaro dai documenti del caso come Walters sia venuto a conoscenza di queste informazioni errate.

OpenAI deve pagare il risarcimento?

Dal punto di vista legislativo, OpenAI ha effettivamente delle responsabilità se la sua IA genera risposte false, talmente false da rappresentare diffamazione?

Eugene Volokh, un professore di Giurisprudenza che ha scritto articoli e saggi sulla responsabilità legale delle IA, ha osservato in un post sul suo blog che, sebbene ritenga che “tali richieste di risarcimento per diffamazione contro le aziende di IA siano in linea di principio legalmente fattibili”, questa particolare causa “dovrebbe essere difficile da sostenere“.

Volokh osserva che Walters non ha notificato a OpenAI queste false affermazioni, dando loro la possibilità di rimuoverle, e che non ci sono stati danni effettivi come risultato della produzione di quel testo generato da ChatGPT. “In ogni caso, sarà interessante vedere cosa succederà alla fine“, afferma Volokh.

Qualsiasi cosa accada, questo è un altro segnale che deve farci tenere sempre le antenne dritte. Quando chiediamo qualcosa a ChatGPT, o ad altri chatbot, è necessario fare le opportune ricerche per capire se sia tutto vero ciò che dicono. Può sembrare controintuitivo, visto che queste IA servono proprio a bypassare le ricerche sui motori di ricerca, ma bisogna tener presente che quetsi sistemi sono ancora imperfetti.