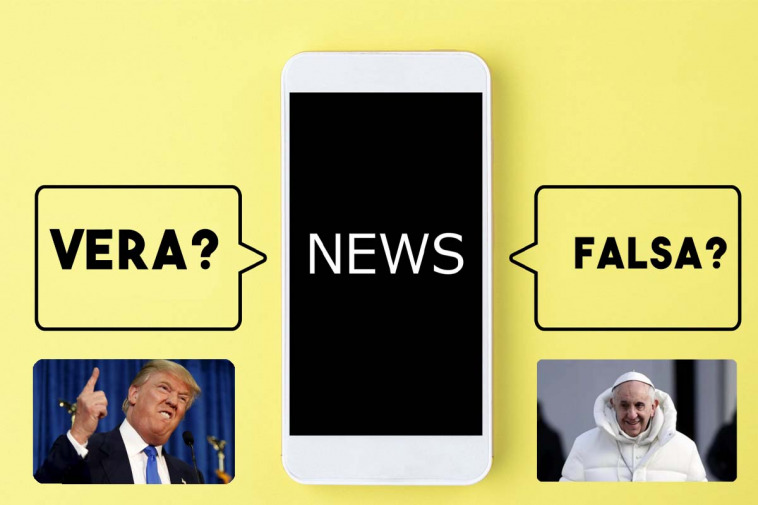

Le fake news sono diventate un problema sempre più grave e diffuso nell’era digitale. La situazione si sta facendo ancora più pericolosa con l’avvento delle intelligenze artificiali in grado di generare immagini che sembrano autentiche.

Le IA in grado di generare immagini realistiche che sono state sviluppate utilizzando tecniche di deep learning riescono ad apprendere dai dati esistenti per creare nuove immagini che sembrano autentiche, anche se in realtà sono state generate artificialmente. Ciò significa che le immagini create possono essere difficili da distinguere da quelle reali, aprendo la strada a un nuovo livello di manipolazione e disinformazione.

La capacità di generare immagini false realistiche può essere sfruttata per scopi malevoli. Ad esempio, politici, personaggi pubblici o influenti potrebbero essere ritratti in situazioni compromettenti o coinvolte in eventi falsi. Queste immagini false potrebbero diffondersi rapidamente sui social media e nei mezzi di comunicazione, creando confusione e minando la fiducia nell’informazione.

Le conseguenze di queste immagini generate artificialmente possono essere estremamente dannose. Possono influenzare l’opinione pubblica, manipolare le elezioni, innescare tensioni sociali e politiche, o diffondere teorie del complotto. Inoltre, le immagini false possono danneggiare la reputazione delle persone coinvolte e creare un clima di sfiducia generale verso i media e le informazioni online.

I casi si stanno già moltiplicando, ne sanno qualcosa Trump e il Pentagono.

Quando Trump fu inseguito dalla polizia…

Un caso emblematico che evidenzia i pericoli delle immagini generate artificialmente è quello relativo a una foto che ritraeva l’ex presidente degli Stati Uniti, Donald Trump, inseguito dalla polizia. Questa foto si diffuse rapidamente sui social media, creando indignazione e suscitando discussioni accese. Successivamente si scoprì che l’immagine era stata generata da un’IA e non rappresentava un evento reale.

I più avvezzi a questo tipo di cose, i nativi digitali, e chiunque abbia un senso critico verso l’informazione capì da subito che si trattava di un’immagine fake, ma non mancarono persone che, invece, ci credettero. D’altronde chi crede a una fake news, quasi sicuramente crederà a una notizia manipolata se al suo interno c’è anche un’immagine che sembra vera.

Questo caso dimostra come le immagini generate artificialmente possano facilmente ingannare il pubblico e generare reazioni emotive intense. Le persone tendono a considerare le immagini come prove concrete di un evento o di una situazione, ma l’avanzamento delle tecnologie di generazione di immagini mette in discussione la loro affidabilità.

L’immagine di Trump inseguito dalla polizia aveva l’obiettivo di creare una narrazione negativa attorno all’ex presidente e alimentare l’indignazione pubblica. La sua diffusione su larga scala ha dimostrato quanto sia facile manipolare l’opinione pubblica e influenzare il dibattito politico utilizzando immagini false.

Questo caso ha sollevato diverse questioni riguardo all’etica dell’utilizzo delle immagini generate artificialmente.

Il caso del Pentagono in fiamme

Qualche giorno fa, un’immagine creata dall’intelligenza artificiale, e twittata, che suggeriva una grande esplosione al Pentagono, ha generato un bel po’ di caos che fortunatamente è subito rientrato; l’evento ha comportato anche un piccolo calo del mercato azionario. L’immagine proveniva da un account Twitter verificato chiamato “Bloomberg Feed”, non affiliato alla nota società di media Bloomberg, ed è stata rapidamente smascherata come una bufala. Tuttavia, prima che venisse smascherata, grandi account come Russia Today avevano già diffuso la notizia, come riporta il Washington Post.

L’immagine falsa raffigurava una grande coltre di fumo nero accanto a un edificio che ricordava vagamente il Pentagono con il tweet “Large Explosion near The Pentagon Complex in Washington D.C. – Inital Report”. A un esame più attento, le autorità locali hanno confermato che l’immagine non era una rappresentazione accurata del Pentagono. Inoltre, con le sbarre di recinzione e le colonne degli edifici sfocate, sembra un’immagine generata dall’intelligenza artificiale piuttosto approssimativa, creata da un modello come Stable Diffusion.

Prima che Twitter sospendesse il falso account di Bloomberg, questo aveva un numero totale di post pari a 224.000 tweet e aveva raggiunto meno di 1.000 follower in totale, ma non è chiaro chi lo gestisse o le motivazioni dietro la condivisione della falsa immagine. Oltre a Bloomberg Feed, altri account che hanno condiviso la falsa notizia includono “Walter Bloomberg” e “Breaking Market News”, entrambi non affiliati alla vera organizzazione Bloomberg.

Questo incidente sottolinea le potenziali minacce che le immagini generate dall’intelligenza artificiale possono rappresentare nel regno dei social media condivisi frettolosamente e di un sistema di verifica a pagamento su Twitter. A marzo, immagini false dell’arresto di Donald Trump create con Midjourney hanno raggiunto un vasto pubblico. Pur essendo chiaramente contrassegnate come false, hanno suscitato il timore di essere scambiate per foto reali a causa del loro realismo.

Un conto è il Papa vestito da rapper, ma quando in un tweet falso compare una struttura governativa come il quartier generale del Dipartimento della Difesa degli Stati Uniti, le conseguenze potrebbero essere più gravi. Oltre alla confusione generale su Twitter, il tweet ingannevole potrebbe aver influenzato il mercato azionario. Secondo il Washington Post, l’indice Dow Jones Industrial è sceso di 85 punti in quattro minuti dopo la diffusione del tweet, ma si è ripreso rapidamente.