Interessanti novità riguardo alle intelligenze artificiali, argomento ormai che ha monopolizzato l’opinione pubblica e i mass media. Le IA vanno regolamentate meglio di come si sta facendo ora, quindi a muoversi in quella direzione è addirittura il Presidente degli Stati Uniti, Biden.

Quando si parla di regolamentazione dell’intelligenza artificiale, ci si riferisce alla necessità di introdurre norme e linee guida che definiscano come le IA devono essere sviluppate, utilizzate e controllate per garantire che i loro effetti siano positivi e che non arrechino danni ai consumatori, all’economia e alla società nel suo insieme.

Attualmente, le IA non possono ancora definirsi del tutto regolamentate poiché ci sono ancora molte questioni aperte riguardanti la loro implementazione e il loro impatto sulla società. Ad esempio, ci sono preoccupazioni riguardo alla trasparenza delle decisioni prese dalle IA, alla protezione della privacy dei dati dei consumatori, alla responsabilità civile e legale delle aziende che sviluppano e utilizzano le IA.

Per questo motivo, esistono diverse proposte di regolamentazione dell’intelligenza artificiale a livello internazionale, come il Regolamento Generale sulla Protezione dei Dati dell’Unione Europea (GDPR) o le Linee Guida sull’Etica dell’AI dell’Organizzazione per la Cooperazione e lo Sviluppo Economico (OCSE), ma non esiste ancora un quadro completo e coerente per la regolamentazione dell’IA a livello globale.

La regolamentazione dell’IA deve essere equilibrata per garantire che le innovazioni tecnologiche non siano ostacolate, ma allo stesso tempo debbano essere controllate in modo da mitigare i rischi associati alla loro implementazione e alla loro diffusione nella società. In questo modo, la regolamentazione dell’IA può contribuire a garantire che le IA siano sviluppate e utilizzate in modo responsabile e a beneficio dell’intera società.

Per questi motivi, anche le alte cariche dello stato e le istituzioni si stanno muovendo per cercare di capire meglio la situazione odierna delle IA

L’Antitrust britannico revisionerà le IA

La Competition and Markets Authority (CMA), ovvero l’Antitrust britannico che si occupa di regolamentare il mercato per impedire che possano verificarsi fenomeni pericolosi per i consumatori, come monopoli dannosi per la concorrenza leale, ha fatto parlare di sé in queste settimane per aver impedito l’acquisizione da parte di Microsoft di Activision Blizzard, vista come un rischio per la libera scelta dei consumatori.

Ebbene, la CMA ora ha preso una forte dicisione anche per quanto riguarda l’intelligenza artificiale. Ha annunciato una revisione dei “modelli fondamentali di intelligenza artificiale“, come i modelli di linguaggio (LLM) che supportano ChatGPT di OpenAI e il nuovo Bing di Microsoft. È probabile che anche i modelli di intelligenza artificiale generativa che alimentano le piattaforme di arte come DALL-E o Midjourney di OpenAI rientrino nel campo di applicazione.

La revisione annunciata dalla CMA sulle IA rappresenta un importante sviluppo nell’ambito della regolamentazione dell’intelligenza artificiale, in particolare sui modelli fondamentali di intelligenza artificiale.

La CMA ha dichiarato che la sua revisione si concentrerà sulla concorrenza e la protezione dei consumatori nello sviluppo e nell’uso di questi modelli, con l’obiettivo di comprendere come questi modelli si stanno sviluppando e di produrre una valutazione sulle condizioni e sui principi che guideranno meglio lo sviluppo di questi modelli e il loro uso futuro.

Ciò che è interessante di questa revisione è che copre anche i modelli di intelligenza artificiale generativa a uso artistico come DALL-E e Midjourney di OpenAI. Questo significa che la CMA sta prendendo in considerazione non solo l’impatto delle IA sui consumatori, ma anche su altri settori come l’arte e il diritto d’autore.

Le conseguenze di questa revisione potrebbero essere significative, in particolare per le aziende che sviluppano questi modelli fondamentali di intelligenza artificiale. La CMA potrebbe introdurre regole più rigide e restrittive sullo sviluppo e sull’uso di questi modelli, il che potrebbe limitare l’innovazione e la competitività delle aziende.

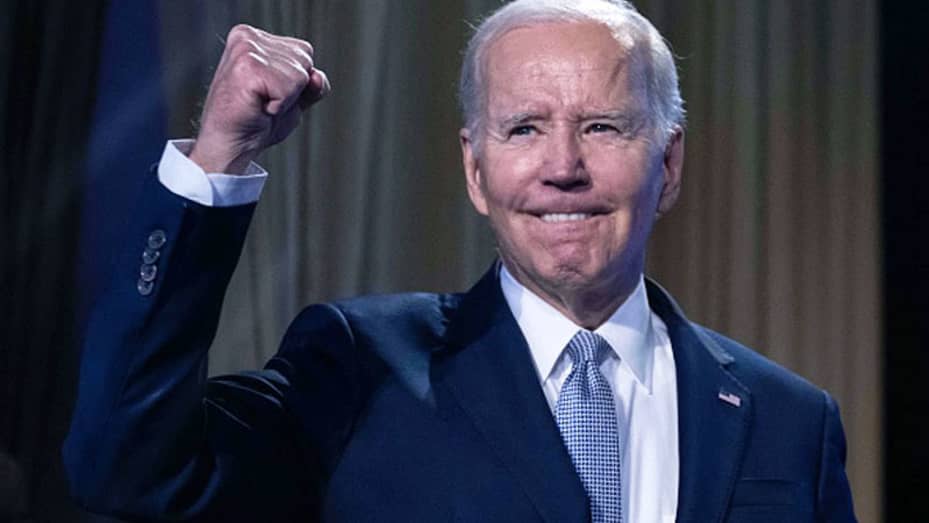

Anche il Presidente degli Stati Uniti vuole vederci chiaro

Il presidente degli Stati Uniti, Joe Biden, ha indetto un meeting con i leader di alcune delle maggiori aziende di tecnologia degli Stati Uniti, tra cui Google, Microsoft, Nvidia e OpenAi, per discutere di questioni relative all’intelligenza artificiale e alla sua regolamentazione.

Ciò che preoccupa il governo americano è l’uso non etico delle IA, così la Casa Bianca ha annunciato maggiori finanziamenti per lo sviluppo di un’intelligenza artificiale responsabile in vista di un incontro dell’amministrazione Biden con i vertici dell’industria.

Le azioni includono un investimento di 140 milioni di dollari della National Science Foundation per lanciare sette nuovi National AI Research (NAIR) Institutes, aumentando il numero totale di strutture dedicate all’IA a 25 in tutto il paese. Google, Microsoft, Nvidia, OpenAI e altre aziende hanno anche accettato di consentire la valutazione pubblica dei loro modelli di linguaggio. L’Office of Management and Budget (OMB) ha anche dichiarato che pubblicherà regole provvisorie quest’estate per illustrare come il governo federale dovrebbe utilizzare la tecnologia AI.

Si legge nel comunicato stampa dell’amministrazione:

Questi passi si basano sul forte impegno dell’Amministrazione per garantire che la tecnologia migliori la vita del popolo americano e aprono nuove prospettive per l’impegno continuo del governo federale per avanzare in modo coeso e completo nei confronti dei rischi e delle opportunità correlate all’IA.

Ad aprile, la Federal Trade Commission, il Consumer Federal Protection Bureau, il Dipartimento della Giustizia e la Commissione per le Opportunità di Lavoro hanno emesso un avviso congiunto sostenendo che avevano già l’autorità per perseguire le aziende i cui prodotti AI arrecano danno agli utenti.

Insomma, una vera e propria task force sta avanzando per vederci chiaro sulla situazione attuale dell’intelligenza artificiale.

Come sono regolamentate le IA in Italia?

In Italia, le IA sono regolamentate principalmente tramite il Regolamento generale sulla protezione dei dati (GDPR) dell’Unione europea, che si applica anche all’uso di strumenti che supportano l’intelligenza artificiale. Il Garante per la protezione dei dati personali (il Garante della privacy) è l’autorità italiana competente per l’attuazione del GDPR.

Il Garante della privacy ha emesso diverse linee guida e documenti in materia di intelligenza artificiale, che forniscono orientamenti per garantire la protezione dei dati personali nell’ambito dell’uso di queste tecnologie. Ad esempio, nel 2020 il Garante ha pubblicato un documento sulle “Responsabilità in materia di intelligenza artificiale e di algoritmi decisionali“, che fornisce una guida per le organizzazioni che utilizzano queste tecnologie.

Inoltre, il Garante della privacy ha recentemente intimato a OpenAI, l’azienda statunitense che sviluppa la tecnologia di intelligenza artificiale GPT-3, di rivedere le sue policy di utilizzo dei dati personali in conformità con il GDPR. Questa decisione è stata presa in seguito all’analisi della documentazione fornita da OpenAI al Garante, che ha rilevato alcune problematiche riguardanti la protezione dei dati personali degli utenti italiani.

Per un breve periodo di tempo, infatti, ChatGPT ha interrotto la sua attività in Italia, con il sito web che risultava inaccessibile. Dopo circa una ventina di giorni, tutto è tornato alla normalità a seguito delle rassicurazioni e della documentazione che la società ha inviato al Garante.