Si parla tanto di rischi legati alle AI, ma quasi mai di rischi che corrono le AI!

Ah, le intelligenze artificiali! Ci distruggeranno, prendendo il sopravvento sugli esseri umani e pensando al posto nostro! Che Dio ci aiuti!

Ma no, le AI miglioreranno la nostra vita sotto ogni aspetto! Semplificheranno moltissimi lavori lasciandoci liberi di dedicarci ad attività più proficue! Faranno risparmiare tempo e denaro efficientando i processi produttivi e trasformando la fantascienza in realtà!

Nel dibattito furioso tra apocalittici e integrati riguardo la AI manca spesso un tassello fondamentale di che nessuno sembra mai prendere in considerazione: la sicurezza delle AI stesse. Con “sicurezza” intendo precisamente la loro protezione da attacchi esterni. Le intelligenze artificiali sono strumenti dalle enormi potenzialità, ma non sono certo impermeabili ad attacchi informatici. Gli hacker possono intrufolarsi ovunque, AI comprese, danneggiandole in vari modi: possono introdurre codice malevolo nell’algoritmo, o possono fornire loro istruzioni che ne modifichino il comportamento rendendole per così dire delle “AI malvage”. Fortunatamente gli esperti di cybersicurezza si stanno rendendo conto dei problemi di sicurezza legati alle AI esattamente in questo senso: occorre rinforzare le misure di protezione delle AI nei confronti di ingerenze esterne, per essere sicuri che svolgano esattamente il compito per cui sono state programmate, senza travisare le istruzioni che vengono loro fornite.

Come fare? Una recente pubblicazione tenta di mettere nero su bianco le problematiche principali che oggi minacciano il corretto funzionamento degli algoritmi di intelligenze artificiali, stilando una tassonomia dei possibili attacchi hacker ai loro danni e suggerendo altresì modalità efficaci di protezione dagli stessi.

4 strategemmi

Scienziati e collaboratori del National Institute of Standards and Technology (NIST) hanno dato alle stampe una recente pubblicazione che accende i riflettori sul rischio di attacchi hacker nei confronti delle intelligenze artificiali, tentando di delineare una classificazione delle tipologie principali di minacce e suggerire soluzioni alle stesse. La pubblicazione, il cui titolo completo è Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations (NIST.AI.100-2), mira a fornire delle linee guida, sviluppate assieme ad esperti governativi e accademici, per dar vita ad algoritmi AI totalmente affidabili.

Apostol Vassilev, uno dei ricercatori che ha contribuito alla ricerca, descrive così lo scopo del progetto:

Stiamo fornendo una panoramica sulle tecniche e metodologie di attacco che considerano tutte le tipologie di intelligenze artificiali. Descriviamo ance le strategie di mitigazione del problema oggi esistenti così come riportate nella letteratura di riferimento, ma i sistemi di difesa disponibili attualmente mancano di garanzie sicure rispetto all’attenuazione completa del rischio. Incoraggiamo la comunità ad industriarsi per la messa a punto di soluzioni più efficaci. – NIST Identifies Types of Cyberattacks That Manipulate Behavior of AI Systems – 4 gennaio 2024

Gli algoritmi di intelligenza artificiale funzionano tanto meglio quanto più sono addestrati e per fare ciò viene loro “somministrata” una mole di dati sempre più impressionante, di varia natura (testuale, fotografico, video, audio…) a seconda dello scopo dall’AI specifica. È proprio in questa fase che risiedono i pericolo maggiori, poiché gli hacker possono insinuarsi in questo processo e manipolare l’algoritmo in modo malevolo. In altri casi possono operare a valle, fornendo input di comando atti ad essere mal interpretati dalla stessa Ai, in modo che essa dia un risultato non previsto rispetto allo scopo per cui è programmata. Per ingannare e/o manipolare le AI, gli hackers possono ricorrere a 4 stratagemmi principali, che sono stati classificati dal NIST come segue:

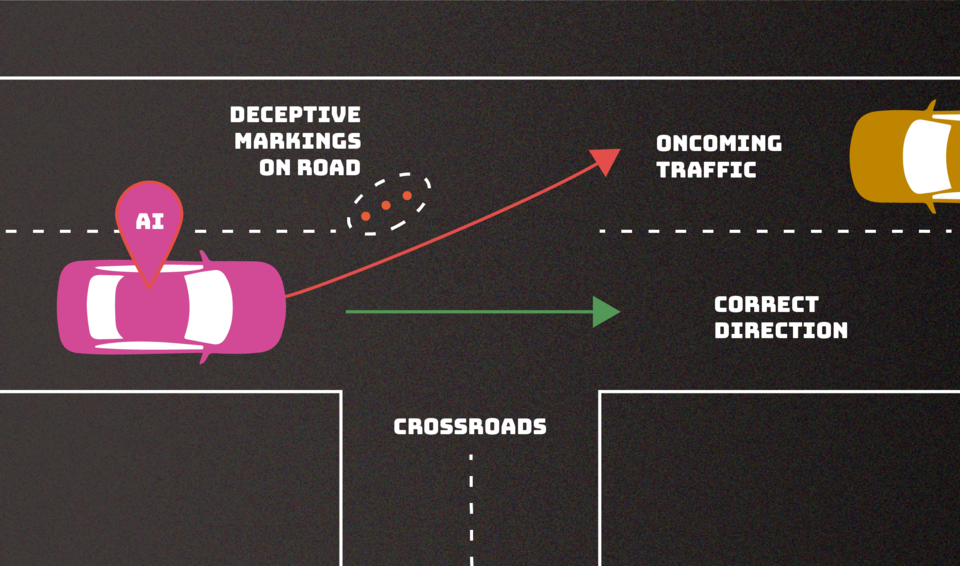

- Evasione: questo tipo di attacco incorre quando l’AI è messa a punto, e consiste nel fornire input ingannatori che portino l’AI a deviare dallo scopo per cui è stata programmata. Un esempio di questo tipo pu avvenire nell’ambito dell’automotive, immaginando ad esempio che gli hacker disegnino a terra segnali stradali contraddittori che ingannino l’AI inducendola a nn fermarsi a uno stop o ad inserirsi nella corsia sbagliata della carreggiata.

- Avvelenamento: questo tipo di attacco avviene nella fase di addestramento e consiste nel fornire all’AI delle informazioni false, fuorvianti o corrotte, che ne alteri il corretto comportamento. Ad esempio in un modello testuale si potrebbe far sì che l’algoritmo impari che il linguaggio scurrile sia in realtà quello preferibile da usare, creando così un modello linguistico particolarmente volgare.

- Privacy: si tratta del tentativo di studiare l’algoritmo al fine di ricavarne informazioni sensibili, derivanti dagli stessi materiali che sono stati usati per addestrarlo. Molto spesso questa pratica viene messa in atto tramite reverse engineering, oppure sfruttando gli stessi input di comando dati all’AI, facendo in modo che si “lasci sfuggire” informazioni che in teoria non avrebbe dovuto divulgare.

- Abuso: s tratta sempre di una forma di corruzione dei dati che vengono forniti all’AI come addestramento, ma in questo caso la corruzione viene fatta a monte. Gli hacker cioè inseriscono informazioni false o ingannevoli in documenti che sanno che verranno “dati in pasto” all’AI, in modo che quest’ultima assorba di default informazioni errate e le dia per vere.

Un bel problema

La difficoltà legata alla sicurezza delle AI non risiede nell’individuazione della tipologia di attacchi hacker perpetrati nei loro confronti – attacchi che, come emerge dal report del NIST, sono stati ormai ben evidenziati e classificati, dunque sono per così dire alla luce del Sole. Il problema principale è che le misure di contrasto a tali attacchi oggigiorno sono piuttosto blande ed inefficaci. Non solo, c’è anche un problema relativo alla facilità di perpetuazione di tali attacchi: detto in parole povere, le AI sono semplici da ingannare, e gli hacker non devono essere chissà quali geni per riuscirci. Spiega Alina Oprea, correlatrice del report e professoressa alla Northeastern University:

Molti di questi attacchi sono piuttosto semplici da imbastire, e richiedono una conoscenza minima dei meccanismi di funzionamento delle intelligenze artificiali, nonché limitate capacità di manomissione; gli attacchi di avvelenamento, ad esempio, possono essere messi a segno manipolando poche dozzine di materiali di addestramento, che costituiscono una percentuale assai esigua di un intero set di training. – ibidem

Il punto fondamentale sostenuto dai ricercatori e che i sistemi di addestramento e più in generale le logiche che fanno capo alla realizzazione degli algoritmi di intelligenza artificiale soffrono ancora di pesanti falle di sicurezza alle quali nessuno ha pensato in sede di concettualizzazione, e che quindi sono difficilmente risolvibili allo stadio attuale. Misure di prevenzione e sicurezza devono quindi cominciare a diventare parte integrante del design e della programmazione di questi sistemi, al fine di mettere a punto sistemi di protezione davvero efficaci.