Qualcuno si ricorda di Copilot Chat, ovvero il chatbot che utilizza un sistema simile a ChatGPT per aiutare i programmatori in difficoltà con qualche linguaggio? Perfetto: GitHub ha lanciato in maniera definitiva questa versione di Copilot per tutti gli utenti disposti a pagare 10 dollari al mese, il tutto dentro i più importanti tool per la scrittura di codice made in Microsoft.

Con dieci dollari al mese GitHub permetterà ai suoi utenti, tutti i suoi utenti, di sfruttare un’intelligenza artificiale ad hoc per sbagliare meno codice. Copilot Chat, questo il nome dello strumento, non è altro che un qualcosa di molto simile a ChatGPT che utilizza le immagini conoscenze nascoste all’interno di tutte quante le pagine di Github per semplificare la vita a una pletora di programmatori.

Meet GitHub Copilot – your AI pair programmer. https://t.co/eWPueAXTFt pic.twitter.com/NPua5K2vFS — GitHub (@github) 29 giugno 2021

Copilot Chat utilizzata il modello linguistico di GPT 4 in una sua versione ottimizzata appositamente per tutto l’universo della programmazione; questo significa che sfruttando il cosiddetto linguaggio naturale (ovvero frasi discorsive molto “standard”) un programmatore può esprimere domande al chatbot ottenendo, in cambio, assistenza in tempo reale. Questa può essere di vario tipo: spiegazione di concetti, debugging rapido, realizzazione di ambienti di test per particolari funzioni e così via.

Qualcuno ha rubato i materiali per l’addestramento?

Come sostanzialmente accade per praticamente tutti quanti i modelli di intelligenza artificiale generativa, Copilot è stato addestrati sfruttando un mischione tra dati disponibili al pubblico o dati protetti da copyright o licenze di qualche tipo. Già da prima della release pubblica di Copilot diverse azioni legali sono state mosse nei confronti di GitHub, Microsoft e OpenAi, nel tentativo di far rispettare i diritti di diverse entità tra violazioni di proprietà intellettuali e sfruttamento errato delle licenze open source.

TechCrunch, per l’occasione, ha anche chiesto a Shuyin Zhao, VP del product management a GitHub se l’azienda ha intenzione di integrare una funzione di opt out per tutti quelli che possiedono della codebase sulla piattaforma.

Le risposte in tal senso non sono state delle più convincenti, con Zao che ha semplicemente suggerito che “non c’è un meccanismo di Opt Out al momento” e che chi è interessato farà bene semplicemente a rendere private le proprie repository per evitare che queste vengano incluse nei futuri set di addestramento per le intelligenze artificiali.

Chiunque abbia realizzato il codice senza tenere in conto della possibilità di vedere lo stesso sfruttato per fini commerciali senza ottenere in cambio nemmeno un nichelino, beh, a quanto pare doveva pensarci prima per Zao e soci. PEr il momento sembra che GitHub non sia disposto in alcuna maniera a cedere sull’opt-out dei dati di formazione, o almeno non ancora.

Per un codice privo di errori ma pieno di allucinazioni

Un fatto noto è che i modelli di intelligenza artificiale generativa, GPT-4 compreso, hanno la curiosa tendenza ad avere vere e proprie allucinazioni o a inventarsi di sana pianta cose; nell’universo della programmazione questo è un grande problema. Secondo uno studio di Stanford infatti i developer che utilizzano gli assistenti con intelligenza artificiale per il coding tendono a produrre codice meno sicuro rispetto agli altri proprio a causa dei frammenti di codice difettosi o poco sicuri sfruttati dai modelli di intelligenza artificiale generativa.

Secondo le dichiarazioni di Zao GPT-4, con il training effettuato per GitHub, è più resistente di altri LLM a problemi di “allucinazione” ed ha diverse funzioni per semplificare la vita ai developer; ad esempio il sistema è dotato di filtri per evidenziare in maniera automatica la presenza di frammenti di codice poco sicuri o soggetti agli attacchi informatici più noti. Questo comunque non può prescindere dalla presenza di una seconda revisione umana, in grado di cesellare ulteriormente il lavoro dell’intelligenza artificiale

Durante il corso del mese di ottobre il CEO di Microsoft Satya Nadella aveva informato gli analisti che Copilot aveva già raggiunto la cifra di 1 milione di utenti paganti, con oltre 37.000 di questi legati all’universo Enterprise. Questo, però, non risolve un grande problema dell’universo delle intelligenze artificiali: i costi operativi che le aziende che le sfruttano devono sostenere sono imponenti.

Un industria che fatica a risultare profittevole (più o meno)

Secondo dei report pubblicati dal Wall Street Journal, Copilot in tutte le sue iterazioni sostanzialmente fa perdere mensilmente all’azienda che lo sfrutta circa 20$ per utente al mese, con alcuni utenti ancora più dispendiosi che finiscono per far quadruplicare le spesa. L’alto costo operativo delle intelligenze artificiali è un argomento piuttosto noto a chi lavora nel settore, con i progetti più recenti che stanno cercando di allontanarsi dai modelli di aziende come ChatGPT proprio per permettere il funzionamento di chatbot con costi molto più contenuti.

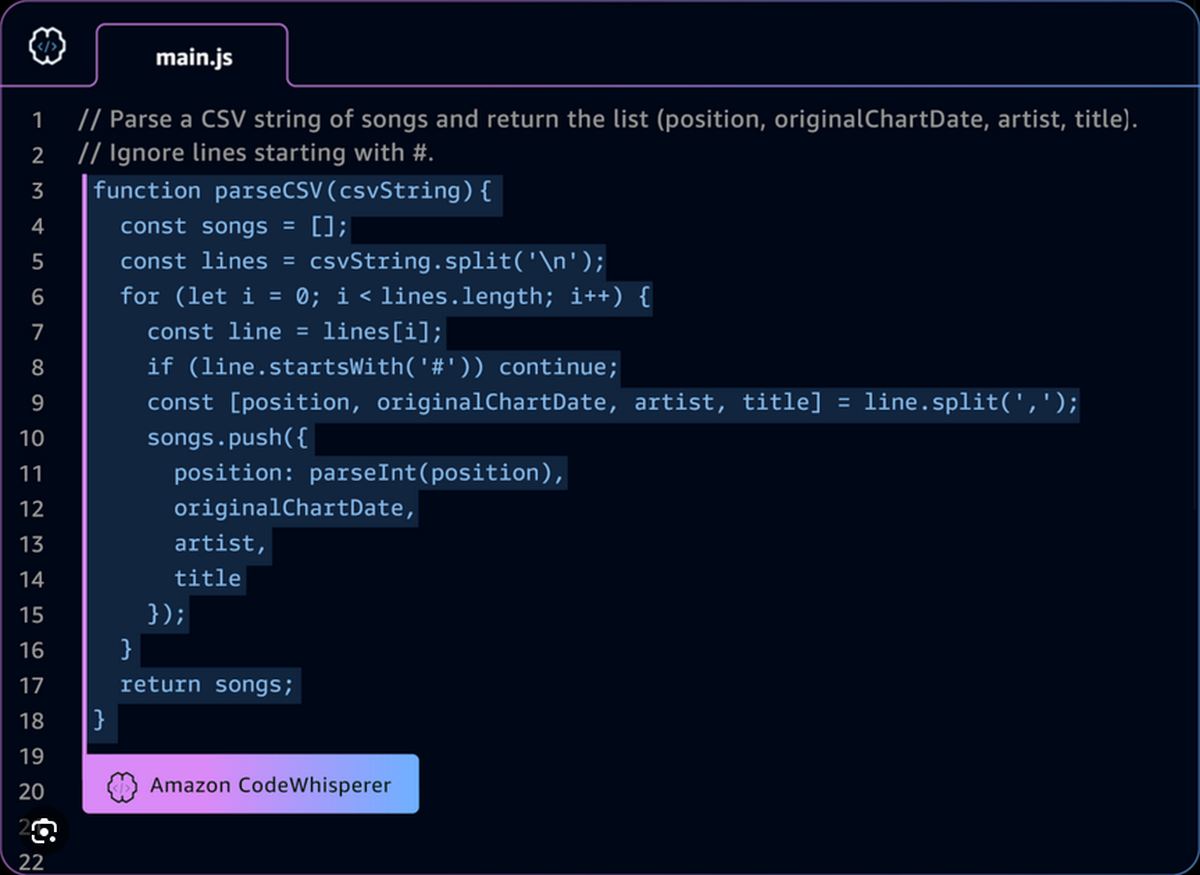

Per il momento, quindi, sembra essere una complessa sfida tra aziende che tentano di donare ulteriore linfa ai loro prodotti. Un perfetto esempio può essere rappresentato dal principale avversario di Copilot, ovvero CodeWhisperer di Amazon che pur essendo qualche passo indietro ha iniziato da un paio di mesi a presentare piani di abbonamento per cercare di controbilanciare le elevate spese operative, con caratteristiche esclusive che possono far gola ai developer come le integrazioni con sistemi e database di codice.

In tutti questi i casi, comunque, resta un problema centrale nell’universo delle intelligenze artificiali generative: i ricavi che vengono fatti attraverso questi sistemi non vengono in alcuna maniera redistribuiti a chi ha fornito, contro la sua volontà o secondo la sua volontà, i dati per il training alle aziende.

Crediamo sia inutile ripeterci ulteriormente sull’argomento, lasciamo giusto un tweet esplicativo che guarda da vicino ad alcune informazioni diventate di pubblico dominio durante una delle cause made in America contro Midjourney.

Midjourney ToS for you. Let me translate :

“We stole so much that there really isn’t a way to trace everything we stole, it is just too much stealing to document. And that’s it.” pic.twitter.com/56vKfzhLre — Bengal (@bengal_art) 26 dicembre 2023