Uno dei problemi fondamentali del mondo delle intelligenze artificiali generative è la qualità del dataset che è stato utilizzato per lo sviluppo dello stesso. Recentemente si è scoperto che LAION-5B, uno dei più noti e utilizzati al mondo, contiene al suo interno materiali che era meglio non avere.

Con l’acronimo CSAM (Child Sexual Abuse Material) si identica una serie di cose di cui faremmo volentieri a meno di parlare, ovvero immagini e contenuti multimediali legati ad abuso sessuale su minori.

Secondo una recente ricerca dello Stanford Internet Observatory capitanata da David Thiel, sembra che LAION-5B, uno dei più importanti dataset di immagini in circolazioni e lo stesso utilizzato, ad esempio, da Stable Diffusion abbia al suo interno oltre 1000 elementi categorizzabili come CSAM; non quello che vorresti mai vedere quando crei l’ennesima immagine di gattini alla guida di monopattini elettrici.

Cosa sappiamo di preciso?

Intorno al mese di giugno sono iniziati a spuntare in giro per il web diversi casi relativi a immagine CSAM false ma realistiche, realizzate attraverso l’utilizzo delle intelligenze artificiali generative in particolari canali del dark web.

Presupposto che l’intelligenza artificiale non è in grado di “inventarsi” niente per il momento, fin da subito i ricercatori avevano ipotizzato l’esistenza di elementi marci all’interno dei dataset utilizzati. Thiel si è mosso proprio in tal senso durante il mese di settembre, iniziando ad analizzare le informazioni e concentrandosi su LAION-5B.

Secondo quanto scoperto LAION-5B includeva al suo interno già diversi esempi di materiali CSAM noti ai ricercatori; questo perché nella vasta gamma di fonti a cui il dataset ha fatto affidamento per la raccolta dati ci sono stati anche piattaforme estremamente popolari come Reddit o X, senza dimenticare una pletora infinita di siti web con infrastruttura WordPress o Blogspot, senza dimenticare poi siti web “per adulti” come XHamster o XVideos.

In seguito alla pubblicazione del rapporto di Thiel, un portavoce di LAION (l’organizzazione che sta dietro la realizzazione del dataset, una no-profit per la precisione) ha rilasciato delle dichiarazioni riguardanti la rimozione temporanea dei dataset.

Non sappiamo ancora come lavorare correttamente con le intelligenze artificiali generative

Il comunicato stampa di LAION parla in maniera chiaro: la piattaforma rimuoverà temporaneamente i dataset di LAION da internet per soddisfare la politica interna di tolleranza zero nei confronti dei contenuti considerati illegali, così da ripubblicare successivamente delle versioni aggiornate dei dataset più in la con i mesi.

Questo, chiaramente, non risolve i problemi tipici delle intelligenze artificiali generative e per il momento sembrano mancare proprio degli strumenti per interagire con questo genere di problematiche. La rimozione dei dataset, infatti, non risolve i problemi dalle persone che ancora possiedono copie di dataset precedentemente scaricati o modelli addestrati in precedenza, vedi ad esempio Stable Diffusion 1.5.

Già Stable Diffusion 2.0 e 2.1 hanno internamente dei filtri dedicati a rendere irraggiungibili la maggior parte dei contenuti considerati non sicuri ma le statistiche sembrano parlare chiaro: Stable Diffusion 1.5 rimane il più popolare sistema utilizzato per la generazione di immagini sessualmente esplicite e per il momento non sembra esserci modo di arginare la cosa.

Quali sono le soluzioni proposte?

Il gruppo di ricerca capitanato da Thiel ha messo subito in chiaro le cose: nonostante siano stati trovati 3226 casi sospetti di contenuti definibili come CSAM all’interno di LAION-5B, questi sono soltanto una stima, anzi, una sottostima e anche piuttosto significativa. Questa stima è così al ribasso proprio perché ci sono dei limiti importanti da parte dei ricercatori nel rilevare e segnalare i file “pericolosi” all’interno di un dataset.

Non ci sono nemmeno soluzioni definite per poter arginare il problema; il rapporto realizzato dallo Stanford Internet Observatory si limita a dire che per il momento chiunque possieda un set di dati derivati da LAION-5B dovrebbe eliminarli in autonomia o dovrebbe venir contattato da intermedieri incaricati di pulire il materiale.

A questa andrebbe aggiunta una disattivazione dei sistemi basati su Stable Diffusion 1.5 in cui non sono presenti i filtri per la generazione di contenuti “opinabili”, con rimozione della possibilità di distribuzione: soltanto soluzioni che al momento risultano inattuabili.

Che cos’è di preciso LAION-5B?

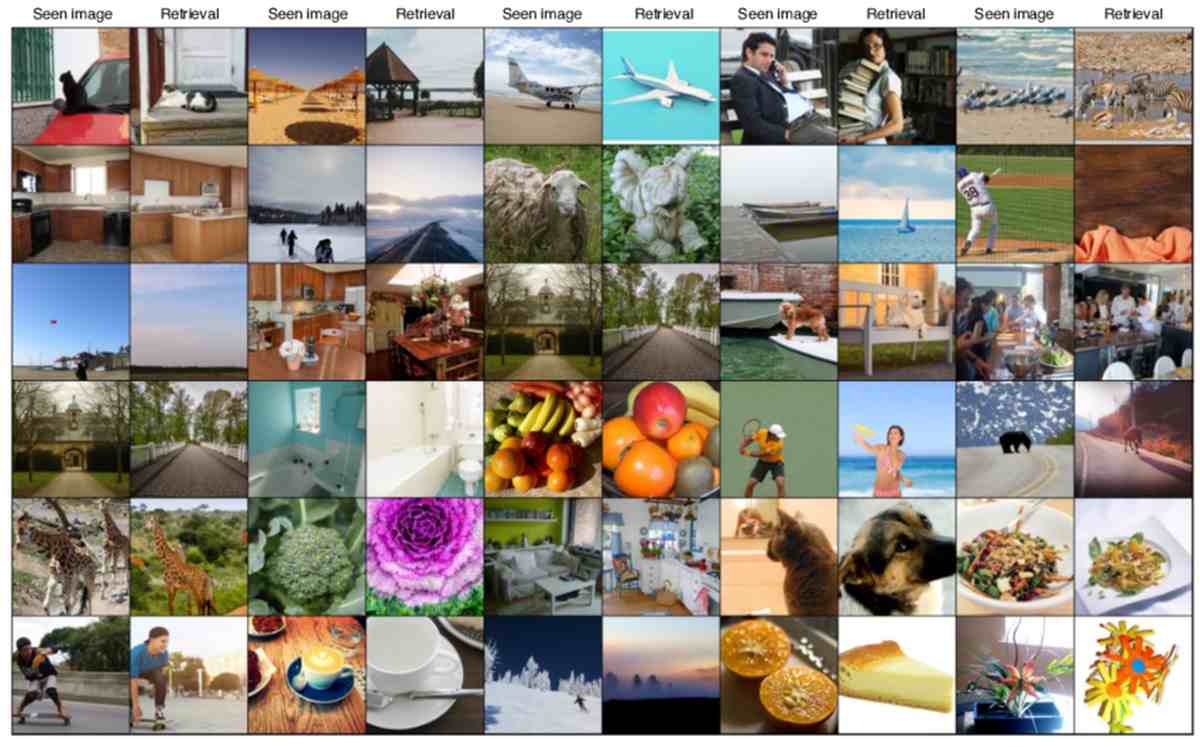

Quando parliamo di LAION stiamo parlando di un gigantesco dataset composto da immagini e testi che vengono utilizzati per effettuare l’addestramento di modelli di intelligenza artificiale; nello specifico il dataset è particolarmente popolare per tutti i modelli che sono in grado di generare immagini partendo da descrizioni di carattere testuale.

Il dataset è stato creato dall’organizzazione no profit tedesca chiamata Large Scale Artificial Intelligente Open Network (LAION, appunto) e contiene ben 5 miliardi di coppie tra immagini e testi raccolte da una grandissima varietà di fonti “pubbliche” in rete.

La loro natura di immagini accoppiate a del testo le rende perfette per addestrare i modelli di intelligenza artificiale attraverso le tecniche di machine learning, permettendo così la creazione di una base dati su cui poi i large language model riescono a generare contenuti in grado di soddisfare le richieste dell’utenza.

La natura aperta di LAION-5B permette a ricercatori e sviluppatori di tutto il mondo di utilizzarlo ai fini di promozione e ricerca dell’intelligenza artificiale ma non mancano ENORMI implicazioni etiche, tanto per la presenza di contenuti sensibili o inappropriati come i CSAM quanto per le destinazioni d’utilizzo di tutti gli elementi generati attraverso i sistemi generativi. Al momento gli stati si stanno ancora muovendo in merito alle regolazioni, con dei primi e importanti passi fatti dall’Unione Europea attraverso la costruzione dell’AI ACT.

Per il prossimo futuro, in sostanza, dataset come LAION saranno di importanza capitale per tutto quell’universo di aziende che stanno muovendo i loro primi passi all’interno del mondo delle intelligenze artificiali generative, di cui abbiamo già abbondantemente parlato nel corso di diverse notizie anche su Player.it

Resta da capire se effettivamente pratiche come l’alghorhitmic disgorgemnt riusciranno a diventare effettivamente utili in tal senso per lo smantellamento da remoto di dataset pericolosi o se gli utenti dovranno fare la guerra alle grandi corporazioni da soli attraverso strumenti come GLAZE; in entrambi i casi parliamo di sviluppi che nel futuro occuperanno chissà quante altre volte le prime pagine dei giornali.