Avete mai sentito parlare di Mistral? Se no questo è l’articolo giusto per voi, proprio perché recentemente il forse rivale di Chat GPT ha annunciato un prodotto in grado di pareggiare con le vecchie versioni del LLM utilizzato da Open Ai, almeno dal punto di vista prestazione.

È recentissima la notizia che Mistral AI, azienda francese specializzata in intelligenza artificiale, ha rilasciato Mixtral 8x7B, un modello per ai generativa basata sulla tecnica MoE, o Mixture of Experts. Quello che ha stupito molti è che, secondo i benchmark, questo tipo di modelli è in grado di affrontare ad armi pari anche il ben più noto GPT-3.5 di Open AI, almeno dal punto di vista delle performance.

La cosa potrebbe non sembrare interessante ma, in realtà, è davvero interessante perché significa che ci stiamo pragmaticamente avvicinando al momento in cui le intelligenze artificiali generative con livelli di qualità di GPT 3.5 saranno disponibili gratuitamente e localmente su dispositivi di vario genere.

Sembra incredibile, vero? Andiamo a scoprire qualcosa in più sull’argomento.

Meno risorse, potenza uguale: promette bene

Mixtral 8x7B è in grado di processare 32K token di context windows (la “finestra di contesto” è il quantitativo di dati che l’ai è in grado di leggere in input) ed è in grado di lavorare in francese, tedesco, spagnolo, italiano e inglese.

Il suo funzionamento è abbastanza simile a quanto abbiamo visto fare da ChatGPT ultimamente; parliamo di uno strumento in grado di assistere l’essere umano in compiti di realizzazione testi, analisi dati, troubleshooting di problemi software e hardware ed è anche in grado di programmare.

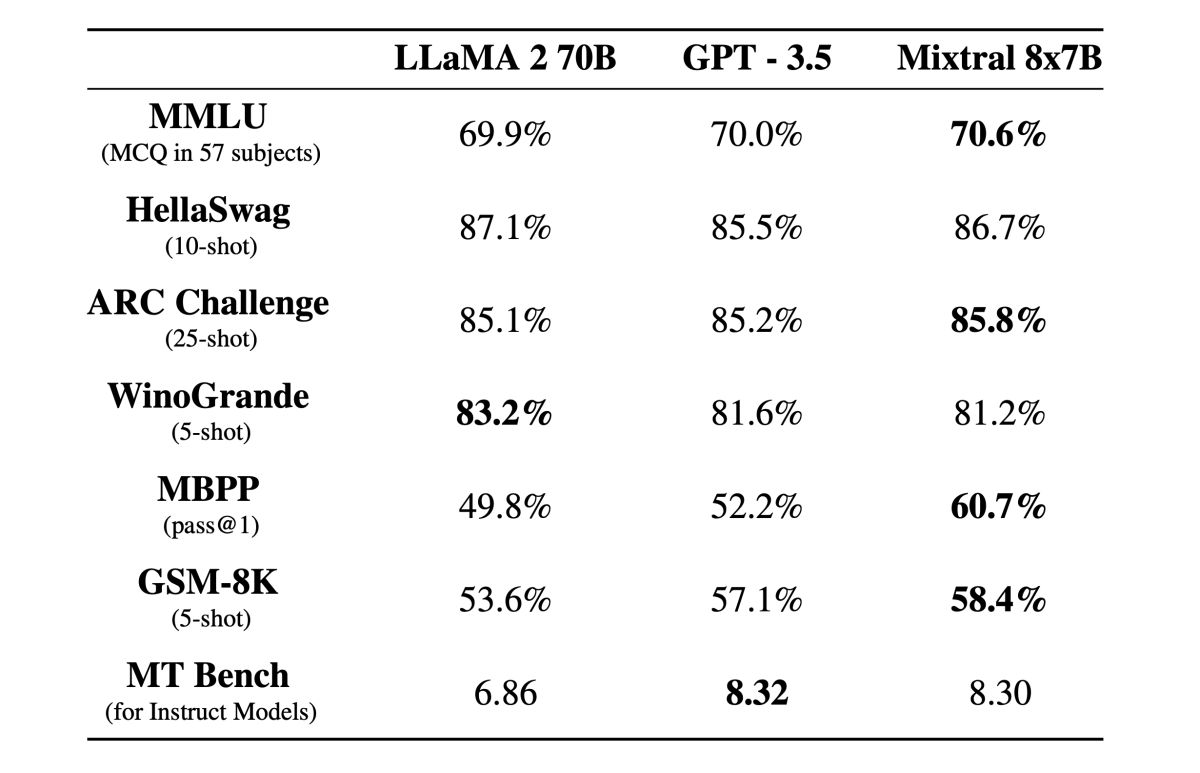

Secondo le dichiarazioni tirate fuori da Mistral, il suo sistema è in grado di superare nei benchmark sia LLaMA 2 70B, il modello realizzato da Meta che ha settanta milioni di parametri ed è in grado di offrire prestazioni paragonabili a quelli di GPT 3.5, dell’arcinota Open AI.

Just incredible. I am running Mistral 8x7B instruct at 27 tokens per second, completely locally thanks to @LMStudioAI.

A model that scores better than GPT-3.5, locally.

Imagine where we will be 1 year from now. 🏃💨 pic.twitter.com/BsHBideReC — Pietro Schirano (@skirano) 11 dicembre 2023

Ad aver sorpreso molti, ad esempio, è la velocità con la quale i modelli di intelligenza artificiale “outsider” hanno raggiunto le prestazioni offerte da Open AI, come fatto notare anche da Pietro Schirano su X o Twitter che dir si voglia.

The Mixtral MoE model genuinely feels like an inflection point — a true GPT-3.5 level model that can run at 30 tokens/sec on an M1.

Imagine all the products now possible when inference is 100% free and your data stays on your device! — Sharif Shameem (@sharifshameem) 12 dicembre 2023

La sua è un opinione condivisa anche da altri volti noti del mondo startup americano, anche Sharif Shameem di Lexicart ha sottolineato con un tweet che è incredibile avere un prodotto in grado di funzionare a una velocità decente, 30 token per secondo, su una macchina come una Mac con processore M1.

A interessare molto gli esperti del settori è la scalabilità di questo genere di strumenti nel futuro prossimo, permettendo la creazione di strumenti di intelligenza artificiale che siano in grado di funzionare completamente in locale, con prestazioni decenti senza incappare in problemi etici derivanti dal training di dati o dai leak di dati che spesso abbiamo visto a causa della natura centralizzata di ChatGPT.

Che diavolo vuol dire MoE?

Scendiamo un minimo nel tecnico per parlare di MoE, o Mixture of Experts: una tecnica di machine learning che utilizza meno potenza di calcolo di quelle utilizzate nei principali prodotti disponibili al momento ma che offre prestazioni paragonabili.

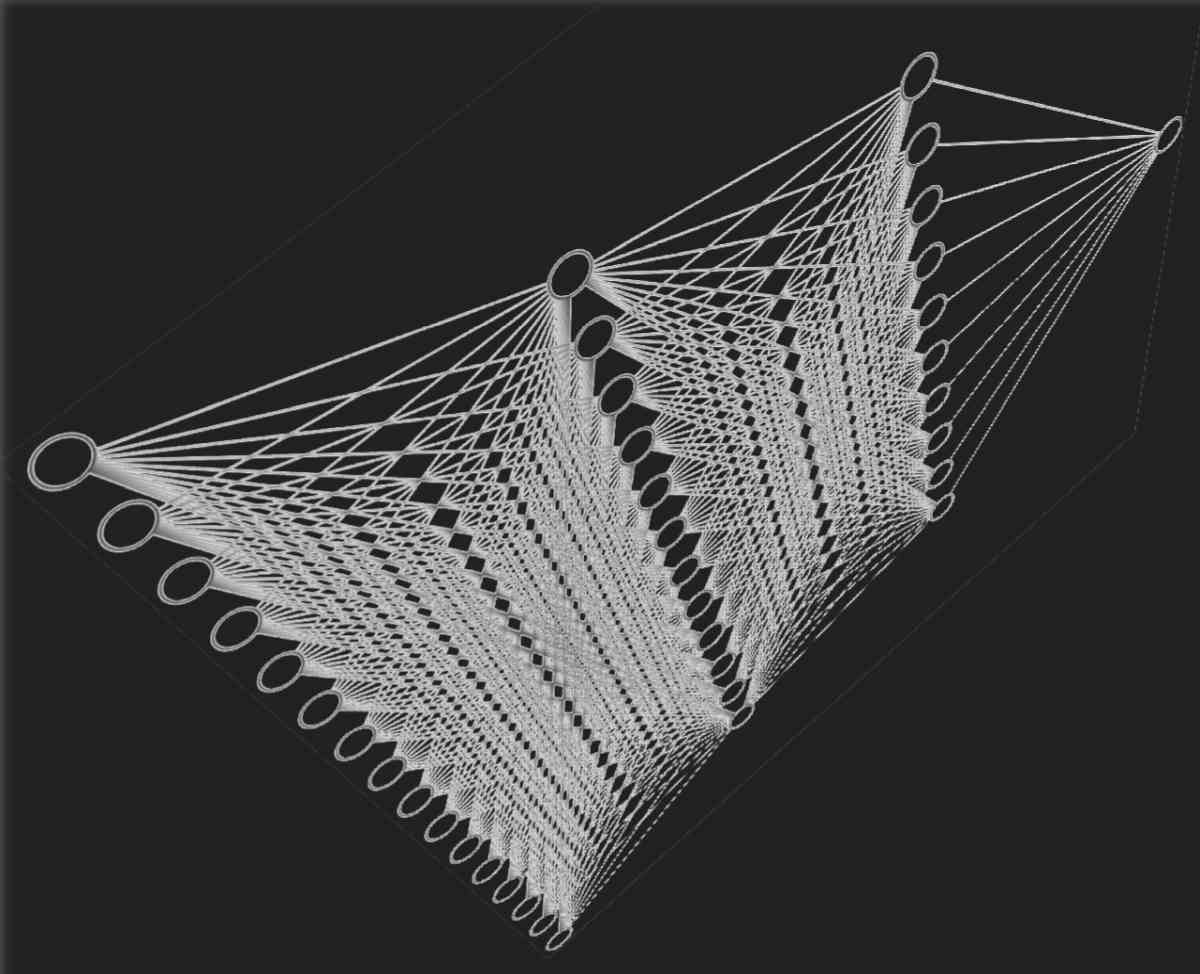

Questo tipo di architettura per i sistemi machine learning è sfrutturata in maniera particolare, con una gate network che indirizza i dati di input a componenti specializzati dalla rete neurale. Questi, definiti anche experts, hanno la capacità di processare in maniera più efficiente i dati in questione offrendo quindi la possibilità di diminuire i consumi, la potenza di calcolo richiesta e di permettere una maggiore scalabilità del modello all’aumentare della potenza.

Per ogni input, infatti, soltanto un frammento dell’intero network di machine learning viene richiamato: questo permette al sistema di avere un carico computazionale inferiore rispetto ai modelli monolitici utilizzati al momento. Anche OpenAI potrebbe star utilizzando un sistema MoE per il suo GPT-4, specie perché determinate performance sembrano lasciar intendere ciò.

In tal senso è molto utile la metafora utilizzata da ArsTechnica sull’argomento. Un sistema MoE assomiglia a una fabbrica con tante tipologie di lavoratori specializzati in compiti particolari (gli experts); questa fabbrica è dotata di un sistema intelligente per la redistribuzione del lavoro (il gate network) che è in grado di scegliere chi sono gli esperti giusti per un compito specifico; i sistemi tradizionali di machine learning fanno lavorare in contemporanea tutti i lavoratori possibili, impegnandoli però meno di quanto riescano a fare al massimo delle loro capacità.

Mixtral non è chiaramente il primo sistema di machine learning di tipo MoE ma è il primo a offrire performance notevoli dato un parameter count (un valore che, all’aumentare, viene associato a ottime prestazioni) basso. I veri smanettoni tra voi lettori potranno provare sul proprio computer Mixtral scaricandolo da Hugging Face e utilizzando LM Studio a proprio vantaggio per eseguire una versione locale del sistema.

Prossimamente Mistral ha anche annunciato l’intenzione di dare accesso a una versione Beta delle sue API per ben tre modelli da essa sviluppati.

Chi è Mistral AI?

Se siete arrivati fino a qui molto probabilmente vi starete chiedendo chi diavolo c’è dietro Mistral AI, di certo molto meno chiacchierata dei grandi nomi dietro lo sviluppo delle intelligenze artificiali.

Mistral AI è una startup francese che si occupa di intelligenza artificiale e che, recentemente, sta ricevendo enormi investimenti da parte dell’azienda di venture capital Andreessen Horowitz, con tanto di collaborazioni con Nvidia e Salesforce.

Fondata dall’ex DeepMind Arthur Mensch e dagli ex dipendenti di Meta Guillaume Lample e Timothée Lacroix, Mistral AI si è posta l’obbiettivo di competere con aziende come Open AI nella creazione di prodotti che sfruttano l’intelligenza artificiale, ottenendo anche risultati interessanti. È chiaro che senza investitori non si riesca a fare molto, considerando il fatto che Open AI può contare sul supporto economico di Microsoft mentre l’altro grande rivale non FAANG, Anthropic, ha ricevuto ingenti fondi da Amazon, Google o Salesforce stessa.

La mission di Mistral AI, come anche sottolineato dalle dichiarazioni di Mensch (che nell’azienda ricopre il ruolo di amministratore delegato), è quella di rendere utile l’intelligenza artificiale, cercando di perseguire tale scopo mettendo in primo piano l’efficienza dei suoi strumenti (e abbassando i costi rispetto alla concorrenza). Fin dalla nascita Mistral è impegnata nella creazione di soluzioni a carattere open source, con l’obbiettivo di dichiarato di cercare di realizzare modelli di intelligenza artificiale generativa legata al testo che siano commercialmente disponibili durante il corso del 2024.

Da un punto di vista economico l’azienda per il momento ha raccolto il supporto di tanti grandi nomi dell’economia e della tecnologia, con 105 milioni di euro raccolti dai primissimi finanziatori a livello globale. Tra le partecipazioni, ad esempio, troviamo Exor: l’holding a cui fa capo anche la famiglia Agnelli.

Curiosa l’idea, rispetto la concorrenza, di realizzare modelli e prodotti open source da modifcare accuratamente poi per scopi commerciali.

Lacroix e Lamble, rispettivamente direttore tecnico e scientifico dell’azienda francese, hanno dichiarato che l’open source è un elemento fondamentale del DNA aziendale ed è pertanto quello che l’azienda cercherà di perseguire con i suoi prodotti. Agli utenti sarà lasciata la possibilità di contribuire con i propri set di dati, un tipo di approccio sostanzialmente opposto rispetto a quello tipicamente proprietario che invece caratterizza le altre grandi aziende del settore.