Lo sappiamo, i modelli di AI proposti finora, presto tardi compiono tutti degli strafalcioni, più o meno gravi. La loro propensione agli errori è inevitabile o arriverà un giorno in cui saranno infallibili?

Chiunque abbia sperimentato l’utilizzo degli algoritmi di LLM, vedi ad esempio ChatGPT e OpenAI, prima o poi si è imbattuto in qualche errore che l’algoritmo ci ha spacciato come verità assodata. Una data piuttosto che un’altra, un’assurdità storica o scientifica, o qualche altro strafalcione che nemmeno un bambino si sognerebbe mai di dire. Una notizia recente, ad esempio, viene dall’Australia, dove un sindaco ha minacciato azioni legali dopo aver scoperto che l’algoritmo lo aveva tacciato di corruzione, ovviamente senza riscontri reali. In generale, le panzane promulgate di tanto in tanto dalle Ai possono avere conseguenze gravi, ad esempio qualora si tratti di consigli medici.

Sorge spontanea una domanda: questi errori occasionali, per quanto rari sembrano presentarsi inevitabilmente prima o poi in tutti questi modelli linguistici. Dobbiamo farci il callo, aspettandoci sempre una minima possibilità di castronerie provenienti dal nostro AI bot preferito, o si tratta ancora di una fase di passaggio, la cui naturale evoluzione porterà ad AI infallibili a prova di errore?

Allucinazione artificiale…

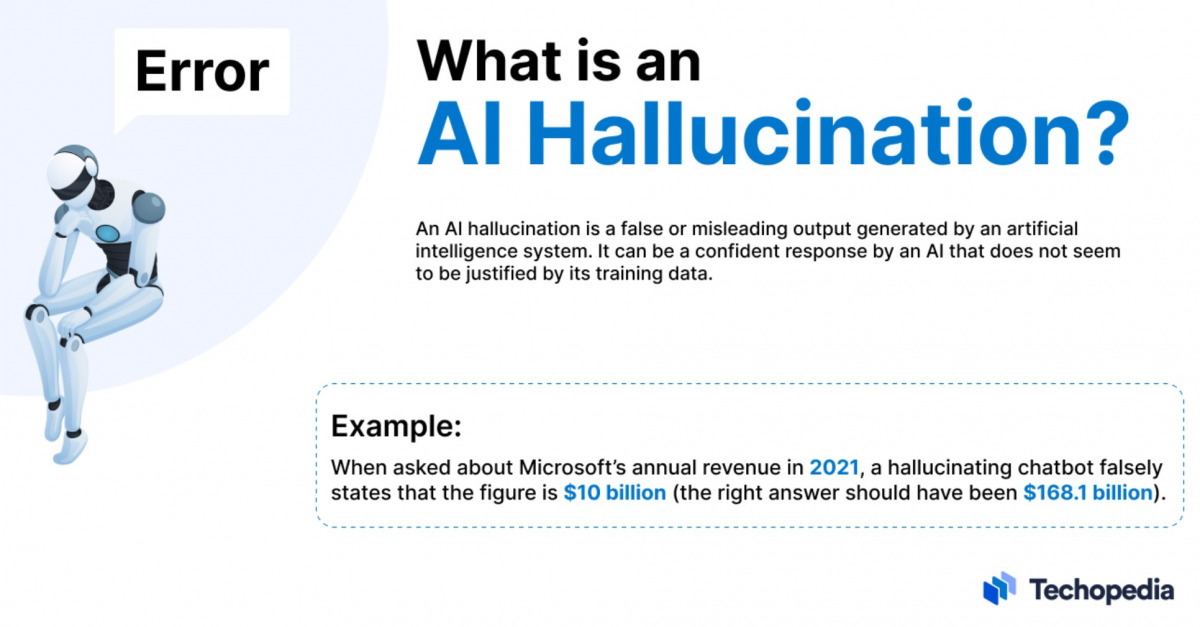

Questi errori sono un fenomeno su cui gli stessi programmatori e sviluppatori si stanno interrogando. In maniera informale, tali errori sono chiamati allucinazioni: le allucinazioni delle AI sembrano essere una conseguenza derivante dal metodo di allenamento cui le AI sono sottoposte.

Tale addestramento consiste “semplicemente” dell’enorme massa di informazioni presente sulla rete, i cui dati sono forniti all’AI per allenare il suo modello linguistico. Importante sottolineare che il modello non è in grado di pensare, anche se le risposte che fornisce danno l’idea del contrario: questo perché l’AI utilizza il serbatoio del web per allenarsi ad esprimersi con un linguaggio naturale, dunque tenderà a completare le frasi sulla base degli infinti esempi che gli sono stati dati in pasto, senza “capire” o “pensare” a ciò che sta effettivamente comunicando.

Sebastian Berns, ricercatore di dottorato presso la Queen Mary University di Londra, ha spiegato a TechCrunch che il modello in questo senso non si discosta troppo dalle funzioni di testo predittivo che troviamo su qualunque smartphone, in cui l’applicazione tenta di indovinare quale sarà il prosieguo della frase che stiamo scrivendo in base agli infiniti esempi precedenti che noi stessi gli abbiamo fornito scrivendo. Sostanzialmente sono modelli basati sulla probabilità, e di conseguenza ammettono per definizione un certo margine di errore.

Dunque l’allucinazione si verifica perché l’algoritmo si concentra sull’elaborare frasi compiute dal punto di vista grammatico e sintattico, pur senza “rendersi conto” del contenuto effettivo della comunicazione trasmessa. Ecco perché abbondano i casi di date sbagliate, o di informazioni false presentate come assolutamente vere, o confondere le stesse fonti di informazione. Insomma, l’LLM non è addestrato a fornire una risposta sempre corretta, bensì “a fornire sempre e comunque una risposta”, del cui contenuto però non capisce assolutamente nulla!

…e terapia artificiale

Dunque come si può curare l’allucinazione artificiale?

Secondo Vu Ha, ricercatore applicato e ingegnere presso l’Allen Institute for Artificial Intelligence, si tratta di una malattia endemica, inestirpabile poiché innata in quest modelli di AI. Tuttavia si può lavorare per ridurne sempre più l’impatto e diminuirne le occorrenze. Ad esempio si potrebbero addestrare gli algoritmi fornendo loro set di domande e risposte scientificamente accurate, in modo da migliorare la precisione delle loro risposte. Ovviamente l’età dell’algoritmo incide sulla sua efficacia: più è lunga la vita dell’LLM, più è ampio il suo addestramento. Per questo gli algoritmo più nuovi sono maggiormente soggetti ad allucinazioni rispetto a quelli più vecchi. In un esempio, Bing Chat ha umiliato Google Bard nel riuscire a rispondere correttamente alla domanda “chi sono gli autori del documento Toolformer?” (Toolformer è un modello di AI addestrato da Meta): Bing Chat ha fornito i nomi di tutti gli sviluppatori mentre il più giovane Bard ha dato una risposta sbagliata.

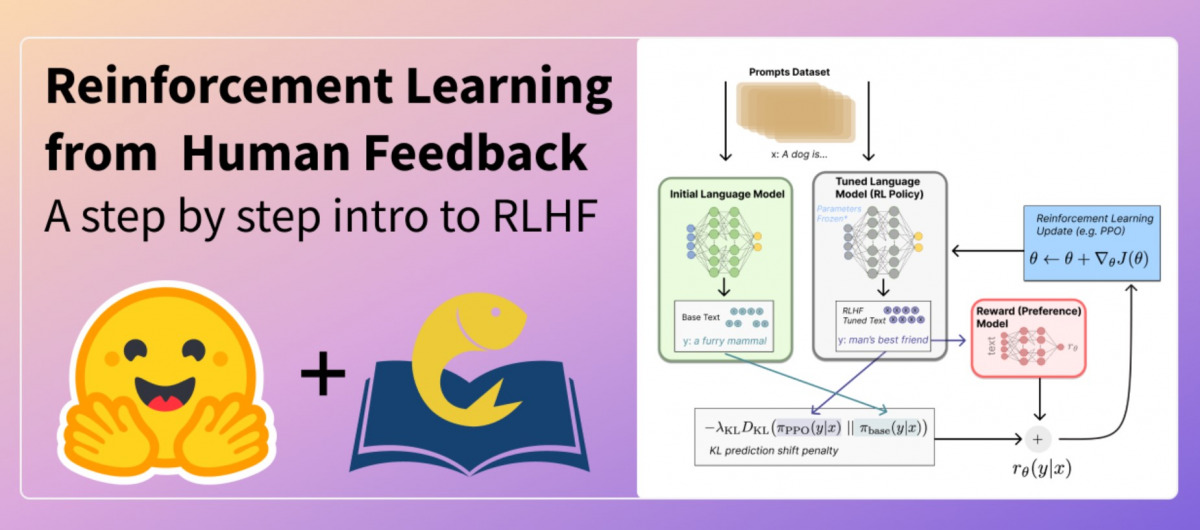

Un altro metodo che si usa è il rinforzo tramite feedback umano (RLHF), con cui si sottopongono le risposte fornite dal modello ad un team di esseri umani che le classifica in base all’utilità, e queste informazioni vengono poi passate all’algoritmo per permettergli di migliorarsi. Ovviamente ridurre gli errori il più possibile massimizza l’utilità del modello, e dunque finché gli errori saranno una percentuale esigua, utilizzare gli LLM risulterà più conveniente rispetto a non farlo.

Allucinazioni creative

Ovviamente l’allucinazione è un problema fintanto che si interroga l’algoritmo in cerca di risposte certe, ovvero lo si usa come oracolo o come motore di ricerca. Ma tutti sappiamo che le interazioni che possiamo sviluppare con l’AI possono avere anche altri scopi, puramente ludici o di supporto creativo: un artista insomma può utilizzare il supporto degli LLM anche solo per fare brainstorming, usandolo con tecniche di libere associazioni per sviluppare un’idea creativa o tematica per un’opera a cui sta lavorando. In quest contesto le allucinazioni possono essere tutt’altro che inutili, anzi, potrebbero fornire punti di vista e idee talmente fuori dagli schemi da risultare stimolanti per una mente artistica.

Dunque l’approccio più corretto all’utilizzo di questi modelli dovrebbe essere quello leggermente scettico o comunque prudente: quando interpelliamo i modelli AI non aspettiamoci risposte scientificamente accurate al 100%, bensì utilizziamo questa interazioni come mezzo per ampliare le nostre possibilità espressive e creative, così facendo lo scambio fornirà sempre feedback interessanti, anche se un po’ allucinanti!