Geoffrey Hinton, uno dei padre dell’intelligenza artificiale, è preoccupato per le conseguenze che tale scoperta potrebbe avere

Da quando le IA generative hanno accentrato le attenzioni dell’opinione pubblica sono nate le prime preoccupazioni. Già Elon Musk, il multimiliardario famoso per il suo aggressivo sfruttamento dell’evoluzione tecnologica, ha messo in guardia sulla necessità di utilizzare le dovute precauzioni prima di sviluppare ancora le intelligenze artificiali.

Ora, altre preoccupazioni arrivano da una voce ancora più autorevole.

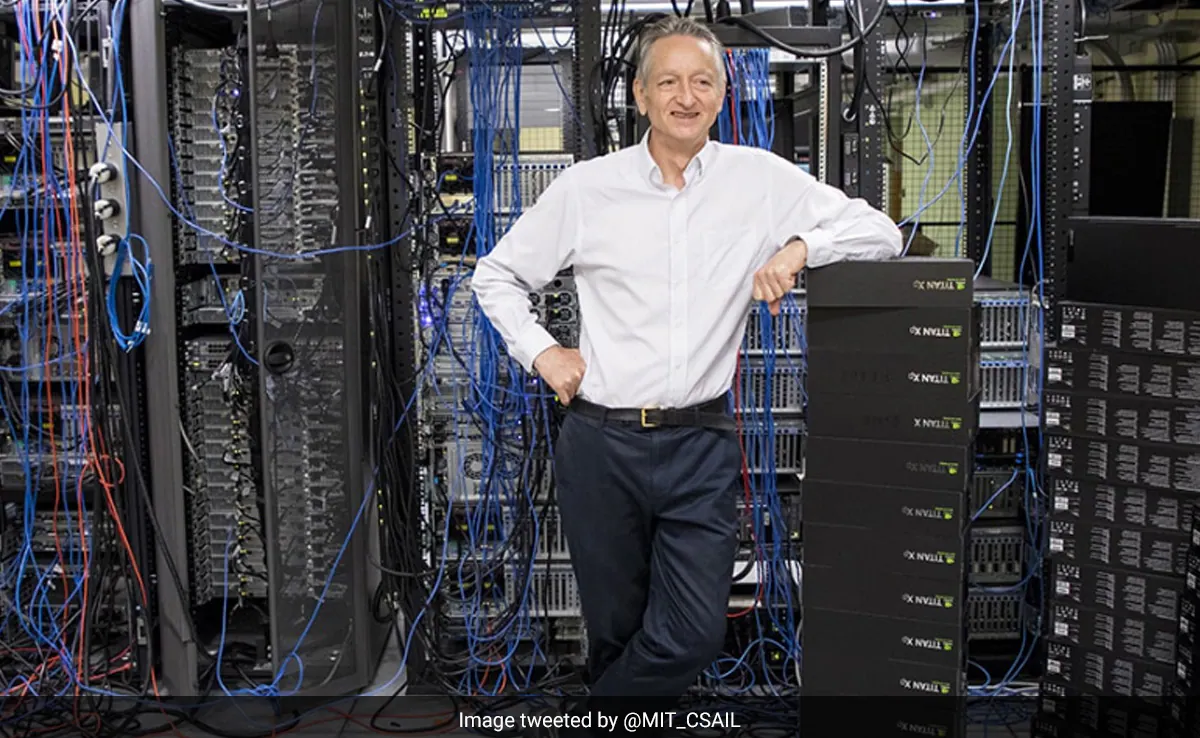

Chi è Geoffrey Hinton

Geoffrey Hinton, conosciuto colloquialmente come il “padrino del Deep Learning”, ha trascorso gli ultimi dieci anni lavorando allo sviluppo dell’intelligenza artificiale presso Google. Ma in un’intervista al New York Times, Hinton ha annunciato le sue dimissioni dal suo incarico e ha dichiarato di essere preoccupato per il ritmo di sviluppo dell’intelligenza artificiale e per il suo potenziale di danno.

Hinton è uno dei principali ricercatori nel campo dello sviluppo dell’IA. La Royal Society, di cui è stato eletto Fellow nel 1998, lo descrive come “distinto per il suo lavoro sulle reti neurali artificiali, in particolare su come possono essere progettate per imparare senza l’aiuto di un insegnante umano” e ha detto che il suo lavoro “potrebbe essere l’inizio di macchine intelligenti autonome simili al cervello”.

Hinton ha continuato il suo lavoro sull’intelligenza artificiale a tempo parziale presso Google – è anche professore all’Università di Toronto – e a guidare i progressi nel campo: nel 2018, ad esempio, è stato co-vincitore del Premio Turing per i “principali progressi nell’intelligenza artificiale”.

Un genio pentito

Recentemente, però, sembra che abbia cambiato radicalmente idea sulla natura del suo lavoro. Parte della nuova preoccupazione di Hinton deriva dalla velocità “spaventosa” con cui lo sviluppo dell’intelligenza artificiale sta avanzando.

L’idea che queste cose possano diventare più intelligenti delle persone, in pochi ci credevano. Ma la maggior parte delle persone pensava che fosse un’idea sbagliata. E io lo pensavo. Pensavo che fosse lontano dai 30 ai 50 anni o anche di più. Ovviamente, non lo penso più Ha detto Hinton

Ciò avviene, almeno in parte, a causa della concorrenza di interessi aziendali, con la corsa di Microsoft e Google allo sviluppo di sistemi di intelligenza artificiale più avanzati. Non è chiaro cosa si possa fare al riguardo: Hinton ha detto di ritenere che la corsa al vertice possa essere gestita solo attraverso una forma di regolamentazione globale, che però potrebbe essere impossibile perché non c’è modo di sapere su cosa le aziende stiano lavorando a porte chiuse. Pertanto, ritiene che spetti alla comunità scientifica intervenire.

Non credo che dovrebbero aumentare la scala fino a quando non avranno capito se possono controllarla Ha detto

Ma anche se gli scienziati decidessero di adottare un approccio più lento e deliberato all’IA, l’inevitabile risultato di uno sviluppo continuo preoccupa ovviamente anche Hinton: “È difficile capire come si possa impedire ai cattivi attori di usarla per fare cose cattive”, ha detto.

È difficile capire come si possa impedire ai cattivi attori di usarla per fare cose cattive Ha spiegato

Fino ad oggi aveva difeso le IA

Gli ultimi commenti di Hinton sono in interessante contrasto con un’intervista del 2016 rilasciata a Maclean’s, in cui esprimeva la necessità di cautela, ma affermava che non doveva essere usata per ostacolare lo sviluppo dell’IA in futuro.

È un po’ come… non appena si dispone di una buona tecnologia meccanica, si possono realizzare cose come le ruspe che possono scavare buche nella strada. Ma ovviamente una ruspa può farti saltare la testa. Ma non è il caso di non sviluppare un retroescavatore perché può farti saltare la testa, perché sarebbe una sciocchezza

Qualsiasi nuova tecnologia, se viene usata da persone malvagie, può accadere qualcosa di brutto. Ma questa è più una questione di politica della tecnologia. Penso che dovremmo pensare all’IA come all’equivalente intellettuale di una ruspa. Sarà molto più brava di noi in molte cose. E può essere incredibilmente buona: le terne ci risparmiano un sacco di scavi. Ma, naturalmente, si può fare un uso improprio

La cosa principale non dovrebbe essere: come possiamo paralizzare questa tecnologia in modo che non possa essere dannosa, ma dovrebbe essere: come possiamo migliorare il nostro sistema politico in modo che le persone non possano usarla per scopi negativi? Spiegava Hinton

Non ha accusato nessuno

Hinton non ha voluto criticare pubblicamente Google o altre aziende se non dopo le sue dimissioni. Lo scienziato ha chiarito su Twitter che non ha lasciato Google per poter parlare dell’azienda, ma per poter “parlare dei pericoli dell’IA senza considerare l’impatto su Google“. “Google ha agito in modo molto responsabile”, ha aggiunto.

Comunque sia, è molto importante che una delle menti più brillanti nello sviluppo dell’intelligenza artificiale avverta che un giorno tutto ciò potrebbe essere molto negativo per noi. La nuova prospettiva di Hinton ha evidenti analogie con il rimpianto di Oppenheimer per il suo ruolo nello sviluppo delle armi nucleari. Naturalmente, il ripensamento di Oppenheimer avvenne dopo lo sviluppo e l’uso della bomba atomica, quando era facile capire quanto il mondo fosse drammaticamente cambiato.

Resta da vedere se anche i rimpianti di Hinton arriveranno dopo che il cavallo è scappato, o se c’è ancora tempo (e una sufficiente capacità di regolamentazione nei governi globali) per evitare il peggio.